高效并行训练大型语言模型:Seq1F1B序列级管道

原文英文,约700词,阅读约需3分钟。发表于:。This is a Plain English Papers summary of a research paper called Efficient Parallelism for Training Massive Language Models: Seq1F1B Sequence-Level Pipeline. If you like these kinds of analysis,...

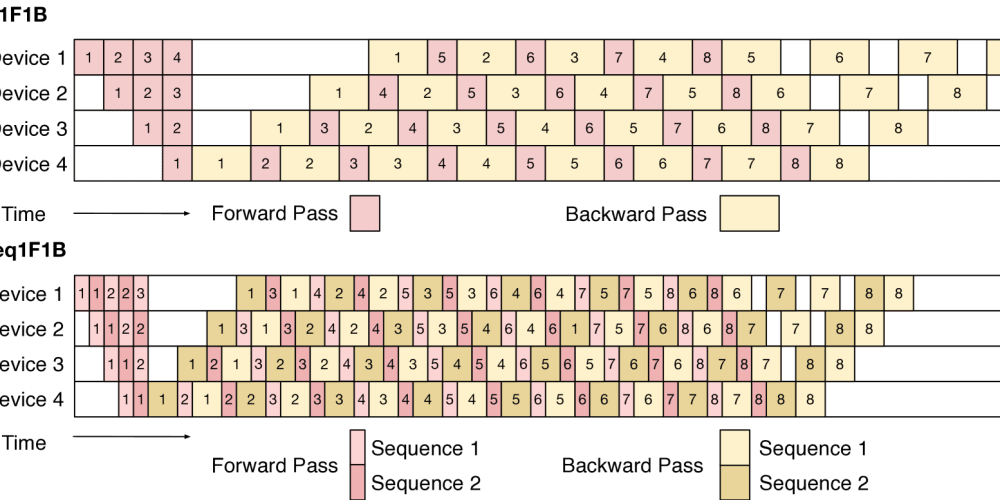

Seq1F1B是一种新技术,用于高效训练大型语言模型。它利用序列级管道并行性来减少内存使用和提高训练速度。通过双向执行方案,Seq1F1B进一步优化资源利用。研究结果表明,Seq1F1B优于以前的并行技术,使训练最先进的语言模型更容易。