💡

原文英文,约900词,阅读约需3分钟。

📝

内容提要

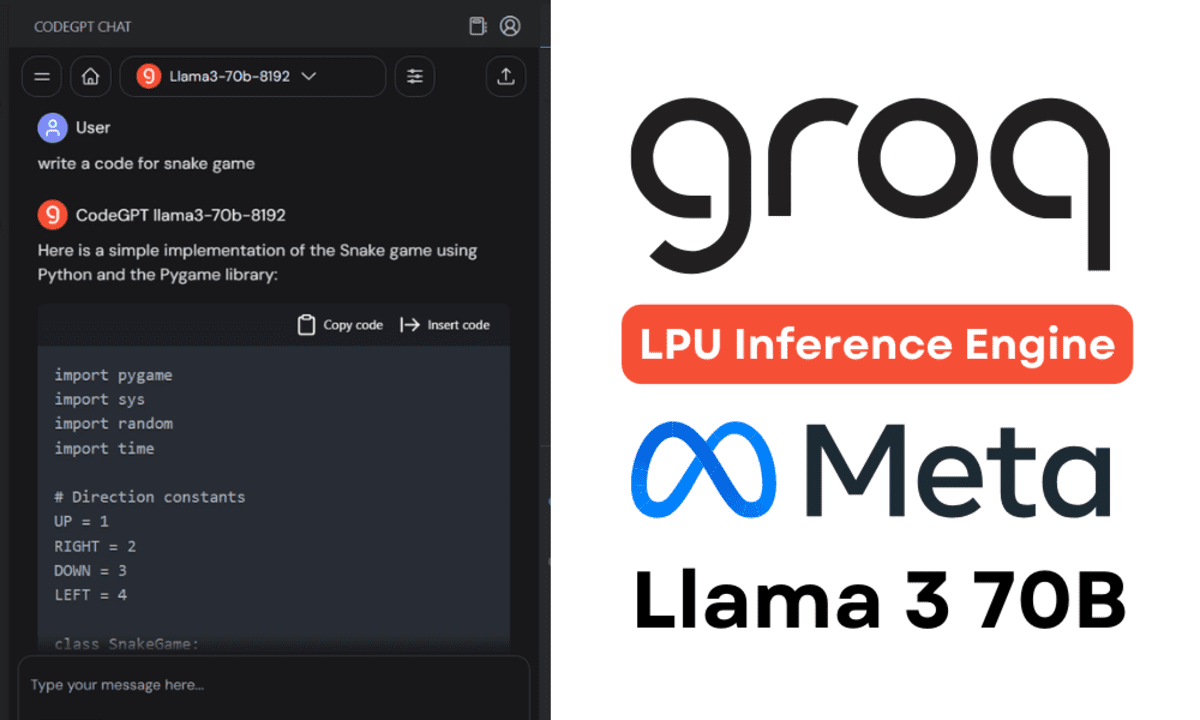

本教程介绍了Groq LPU推理引擎以及如何在Jan AI和VSCode中使用它来生成超快速的响应。通过安装Jan AI和创建Groq Cloud API,可以在本地使用Groq LPU技术,使LLMs变得超快,并在实时AI应用中提供更好的性能。在Jan AI和VSCode中集成Groq,可以生成代码、重构代码、文档化和生成测试单元。这个教程还提供了使用Groq的步骤和注意事项。

🎯

关键要点

- 本教程介绍了Groq LPU推理引擎及其在Jan AI和VSCode中的应用。

- Groq专注于AI基础设施,使大型语言模型(LLMs)运行更快。

- Groq LPU推理引擎旨在为计算密集型应用生成快速响应,尤其是LLMs。

- 与CPU和GPU相比,LPU具有更强的计算能力,能更快生成文本序列。

- Jan AI是一个桌面应用程序,可以在本地运行开源和专有的LLMs。

- 用户需创建Groq Cloud账户以获取API密钥,使用Groq Llama 3。

- 在Jan AI中粘贴Groq Cloud API密钥以使用Groq推理引擎。

- 在VSCode中使用CodeGPT扩展,粘贴相同的API密钥以构建AI编码助手。

- Groq推理引擎提供实时响应,提升开发体验。

- 未来大多数公司将开发自己的推理引擎以匹配Groq的速度。

➡️