💡

原文中文,约5600字,阅读约需14分钟。

📝

内容提要

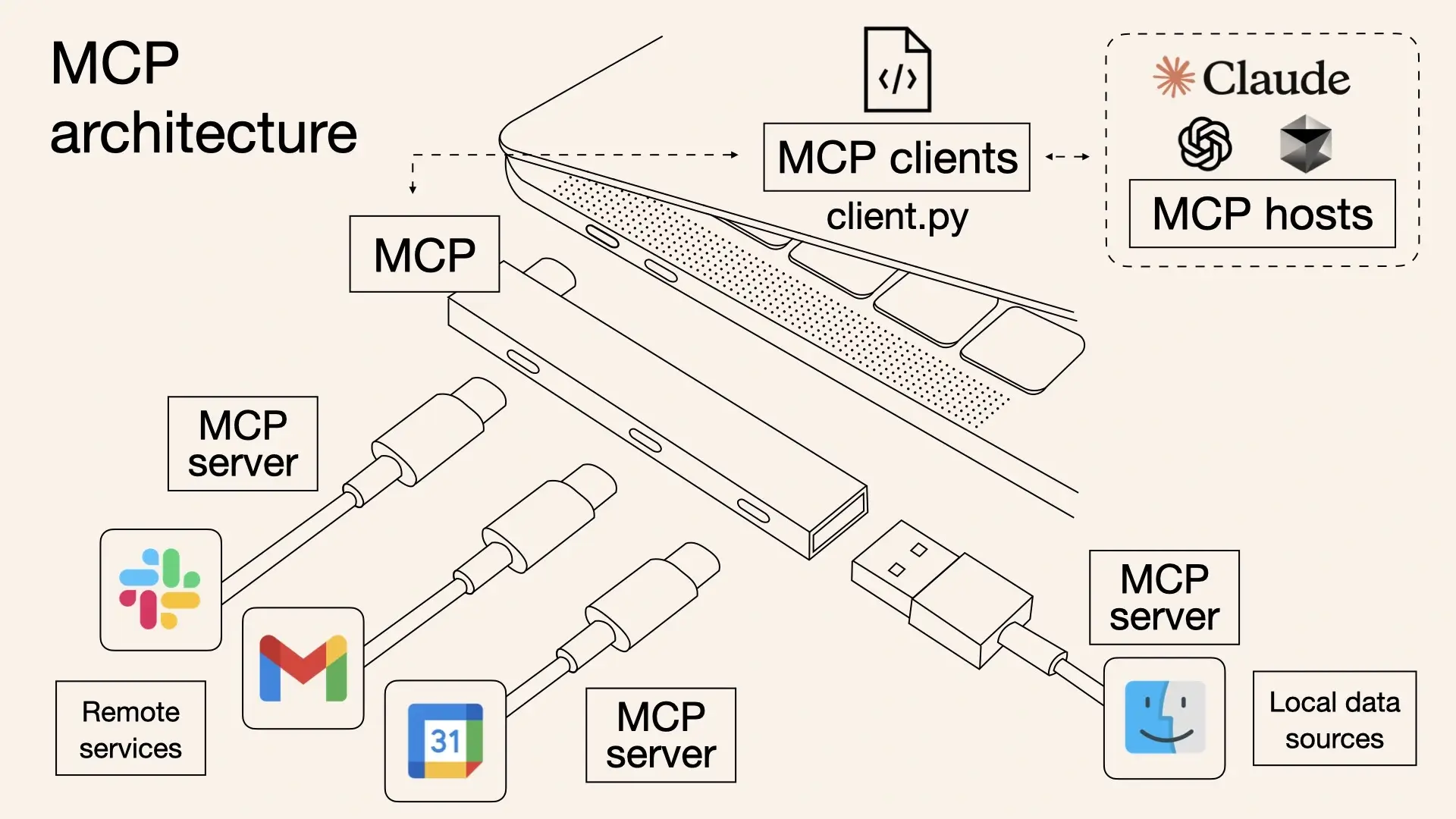

自2022年以来,大语言模型(LLM)逐渐流行,但缺乏与现实世界的交互能力。模型上下文协议(MCP)应运而生,提供标准化接口,使AI能够灵活调用外部工具,提升自动化水平,并解决不同平台间的兼容性问题。MCP通过客户端-服务器架构简化了开发者的工作,增强了AI的实用性。

🎯

关键要点

- 自2022年以来,大语言模型(LLM)逐渐流行,但缺乏与现实世界的交互能力。

- 模型上下文协议(MCP)提供标准化接口,使AI能够灵活调用外部工具,提升自动化水平。

- MCP定义了应用程序和AI LLM之间的交换上下文信息的标准,类似于AI的'USB-C接口'。

- 在没有MCP的情况下,使用AI需要集中发送所有信息,效率低下。

- Function Calling允许AI调用外部工具,但不同平台之间不兼容,增加了开发成本。

- MCP统一了AI与外部工具之间的标准,充当AI模型的万能插头。

- MCP的核心遵循客户端-服务器架构,简化了开发者的工作。

- LLM通过分析可用工具,主动选择并调用合适的MCP Server。

- MCP Server的使用示例包括通过Github进行代码仓库操作。

- 推荐的MCP Server来源包括官方仓库、Awesome-MCP和mcp.so等。

➡️