一分钟读论文:《Blindfold——通过动作级操纵越狱具身大语言模型》

Micropaper

·

一分钟读论文:《洗车问题暴露大语言模型的根本缺陷?提示词架构决定推理质量》

Micropaper

·

自言自语:让大语言模型告别灾难性遗忘

Micropaper

·

Inception Labs表示其扩散大语言模型的速度比Claude、ChatGPT和Gemini快10倍

The New Stack

·

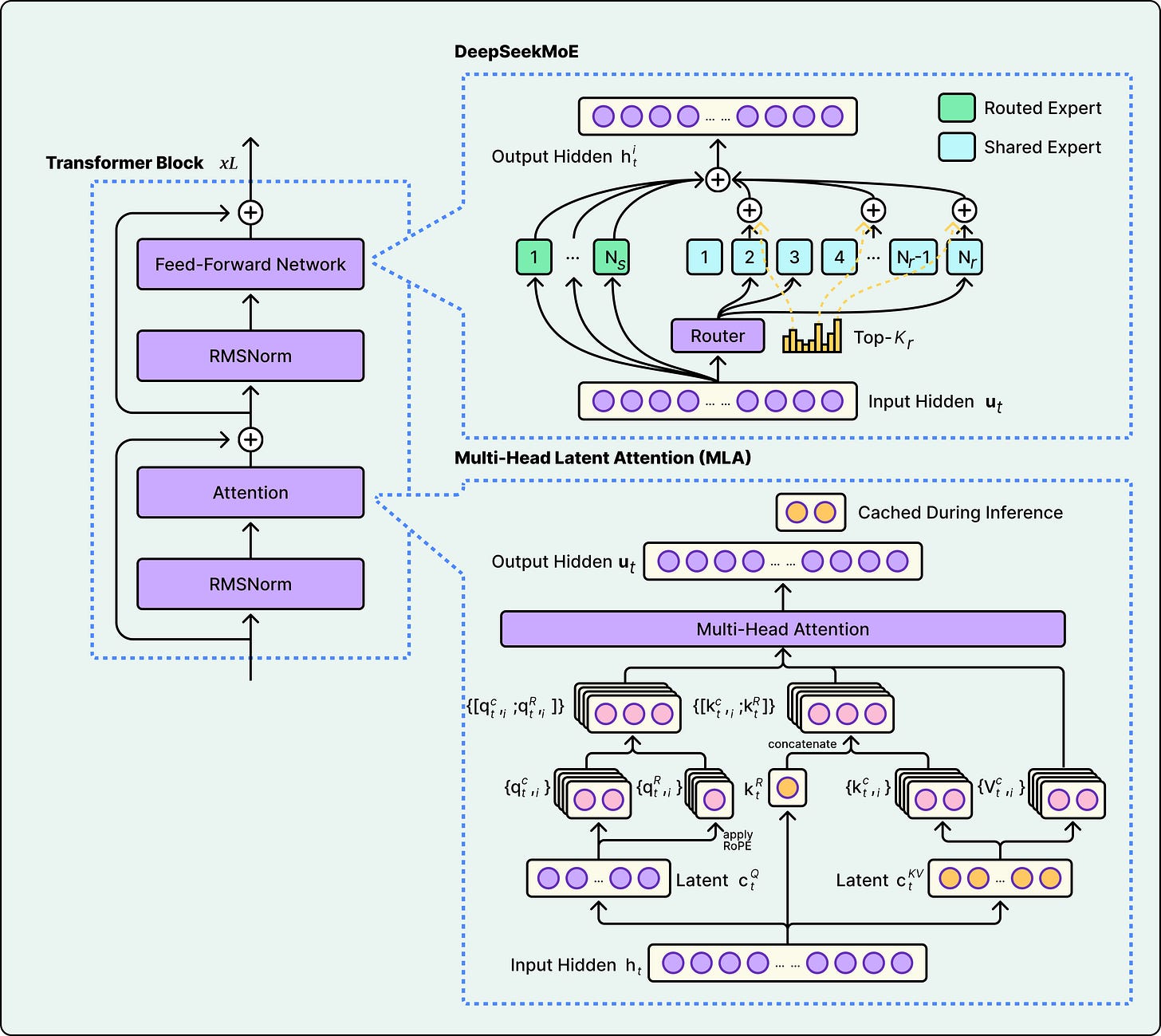

开源大语言模型背后的架构

ByteByteGo Newsletter

·

HRM 架构突破:用仅 2700 万参数和 1000 个训练样本超越最先进的大语言模型

Micropaper

·

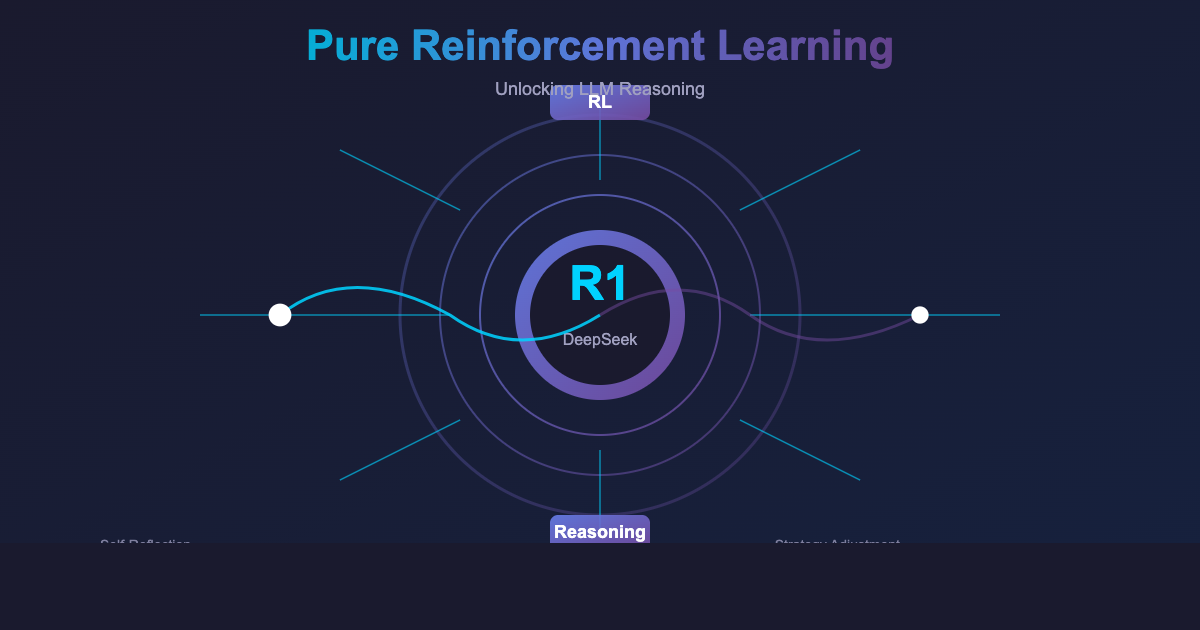

DeepSeek-R1:用纯强化学习解锁大语言模型的推理能力

Micropaper

·

超越单一提取器:重新思考用于大语言模型预训练的HTML到文本提取

Apple Machine Learning Research

·

五大超快速大语言模型API服务商

KDnuggets

·

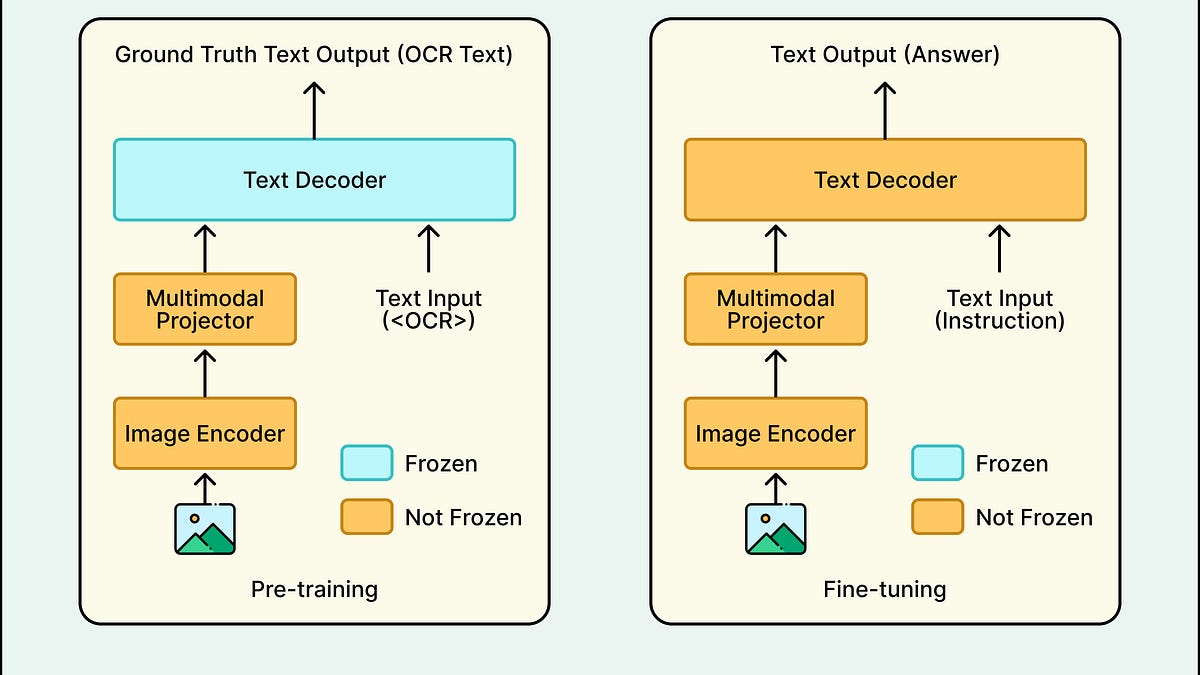

Grab如何构建视觉大语言模型以扫描图像

ByteByteGo Newsletter

·

介绍Kthena:云原生时代的大语言模型推理

Cloud Native Computing Foundation

·