标签

强化学习

相关的文章:本列表汇集了最新的强化学习研究与应用,涵盖从基础算法到前沿技术的多样化内容,助力您深入了解这一领域的创新动态。

Apple Machine Learning Research ·

Apple Machine Learning Research ·

Cursor发布了首个编程大模型Composer,速度达每秒250个tokens,效率提升400%。Cursor 2.0新版本引入原生浏览器工具和语音生成代码功能,支持多Agent协作。Composer通过强化学习训练,能在真实环境中执行编程任务,但模型来源尚不明确。

Apple Machine Learning Research ·

freeCodeCamp.org ·

蚂蚁与港大联合推出PromptCoT 2.0框架,专注于任务合成与强化学习。实验表明,该框架在数学代码推理任务上达成新SOTA,显著提升模型性能。PromptCoT 2.0通过期望最大化优化生成更具挑战性的问题,并开源4.77M合成数据,推动大模型推理能力的提升。未来将探索环境合成与多模态任务。

9.22-9.26 AI 论文推荐

HyperAI超神经 ·

freeCodeCamp.org ·

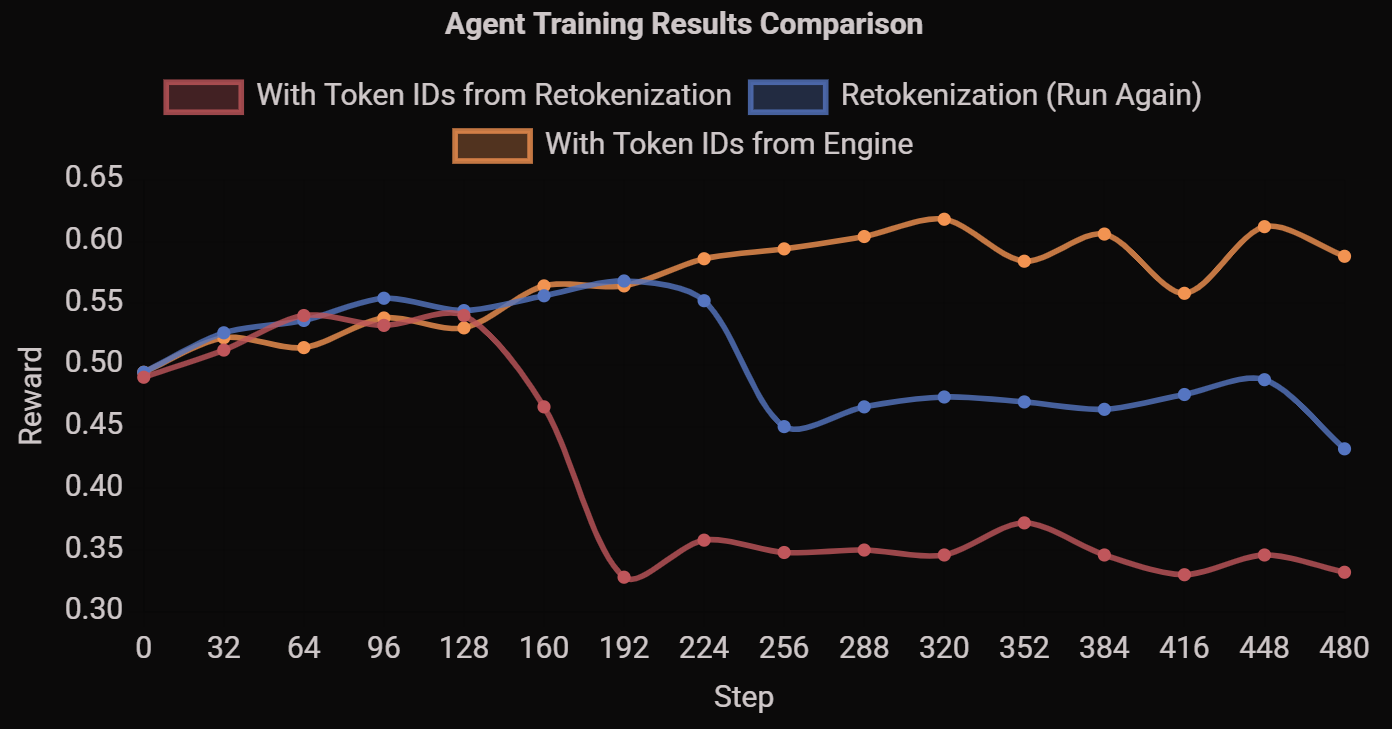

上海交大与字节跳动合作推出RhymeRL框架,训练速度提升2.6倍,且保持精度。该框架通过利用历史数据和新技术,解决了Rollout阶段的低效问题,显著加速AI模型训练。

Meta的强化学习专家Rishabh Agarwal即将离职,曾在谷歌和Meta参与多个重要项目。他的离职引发网友关注,猜测可能与内部矛盾和薪酬问题有关。