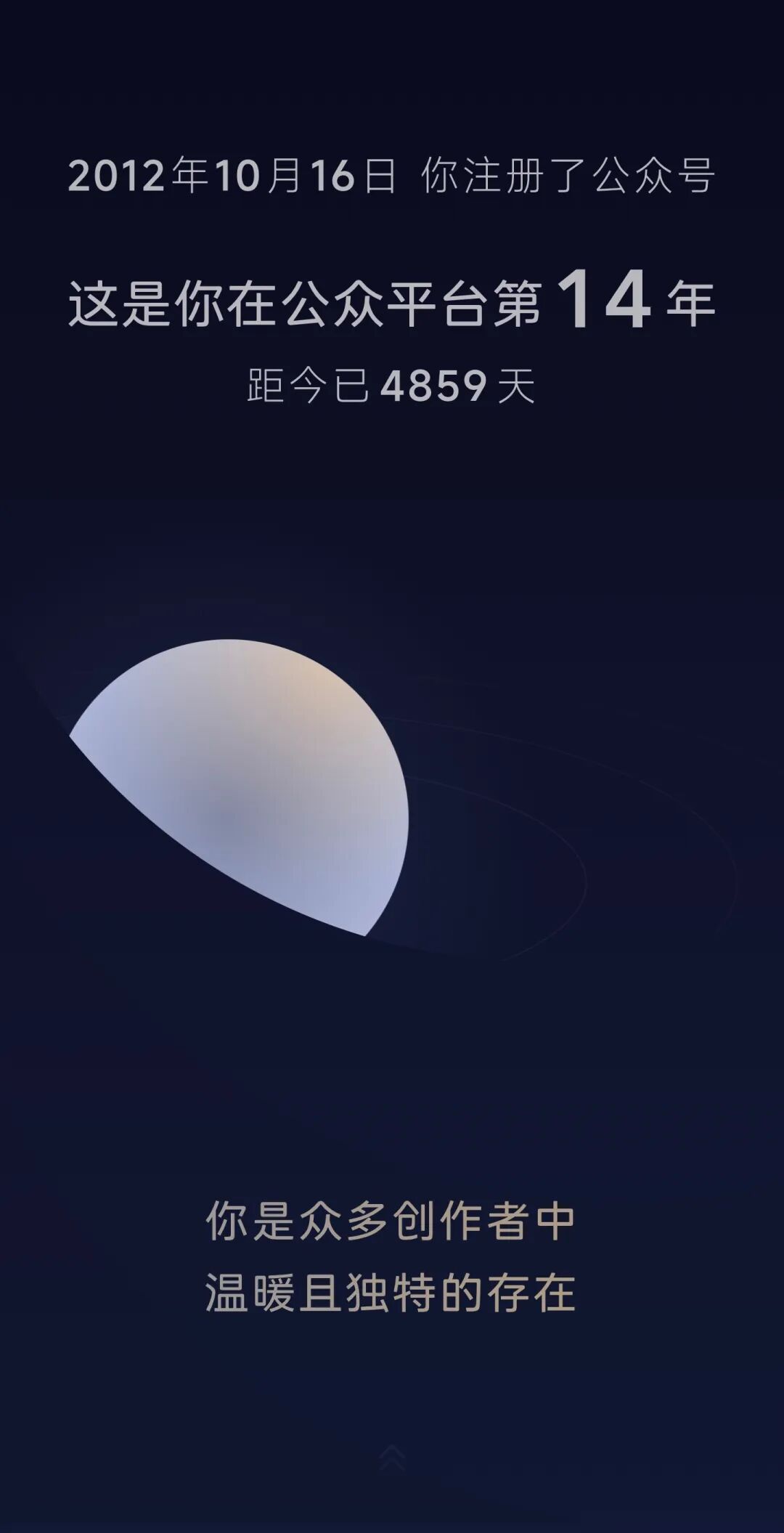

公众号写字 2025 官方总结

joojenZhou 个人网站

·

2025 总结

Shiroha白羽的博客

·

2025年的总结

顾宇的博客

·

Cargo 1.94开发周期总结

Inside Rust Blog

·

巴菲特投资哲学总结

土木坛子

·

一个软件工程师的 2025 电子 DIY 总结

Architecting Life

·

Cargo 1.93开发周期总结

Inside Rust Blog

·