Umair Shahid:PostgreSQL 物化视图:何时缓存查询结果是合理的(何时不合理)

Planet PostgreSQL

·

凯·瓦格纳:Hackorum - pg-hackers 的论坛式视图

Planet PostgreSQL

·

YouTube TV将很快推出自定义多视图和频道套餐

The Verge

·

Deepak Mahto:PostgreSQL表重命名与视图——一个OID的故事

Planet PostgreSQL

·

视图过渡类型的特性检测

Stefan Judis Web Development

·

【小贴士】为什么父视图无法修改子视图的 @State

肘子的Swift记事本

·

.png)

推出自定义日期范围计费视图

The DigitalOcean Blog

·

MongoDB Atlas流处理的实时物化视图

MongoDB

·

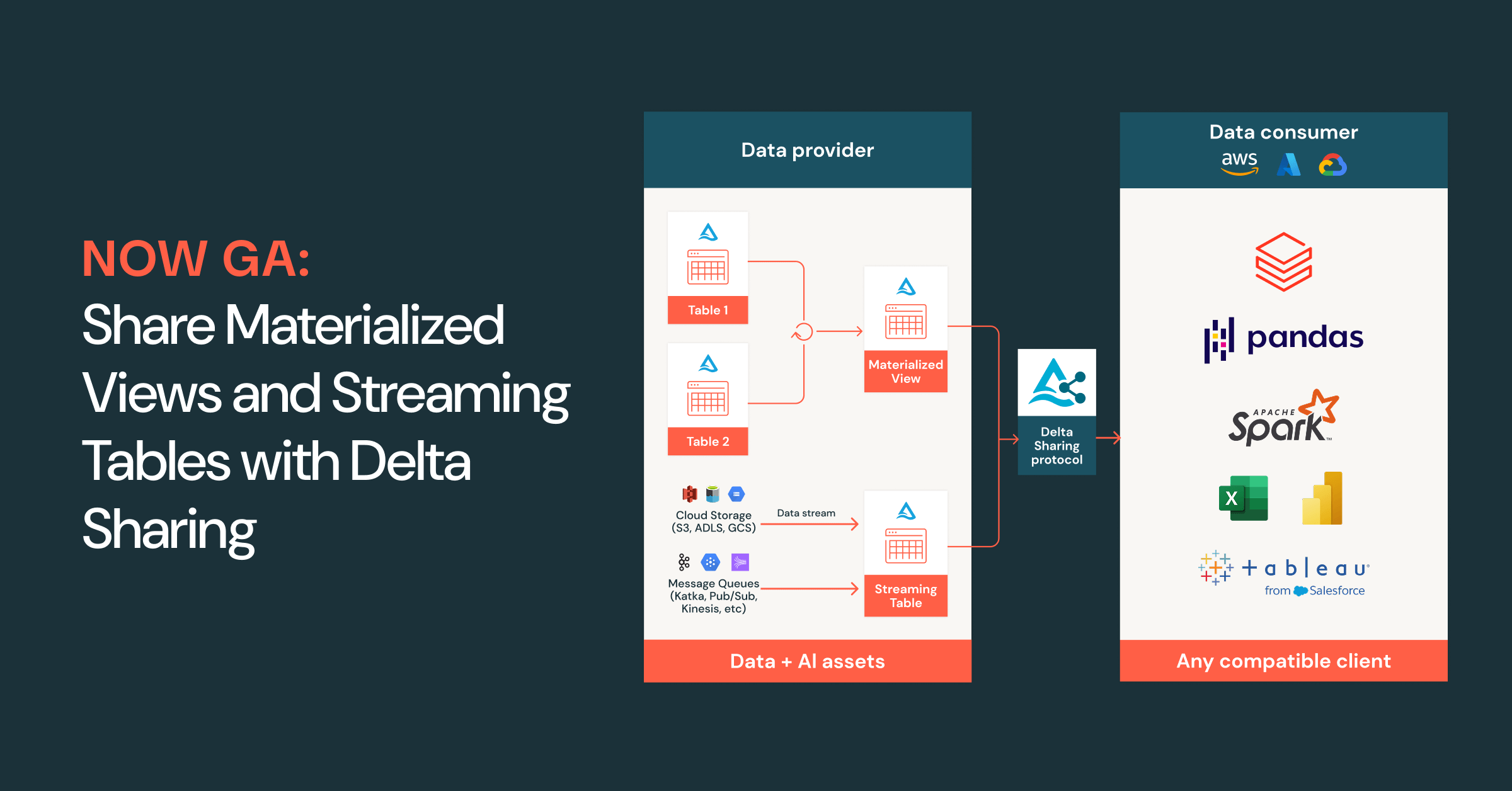

现在正式上线:通过Delta共享分享物化视图和流式表

Databricks

·

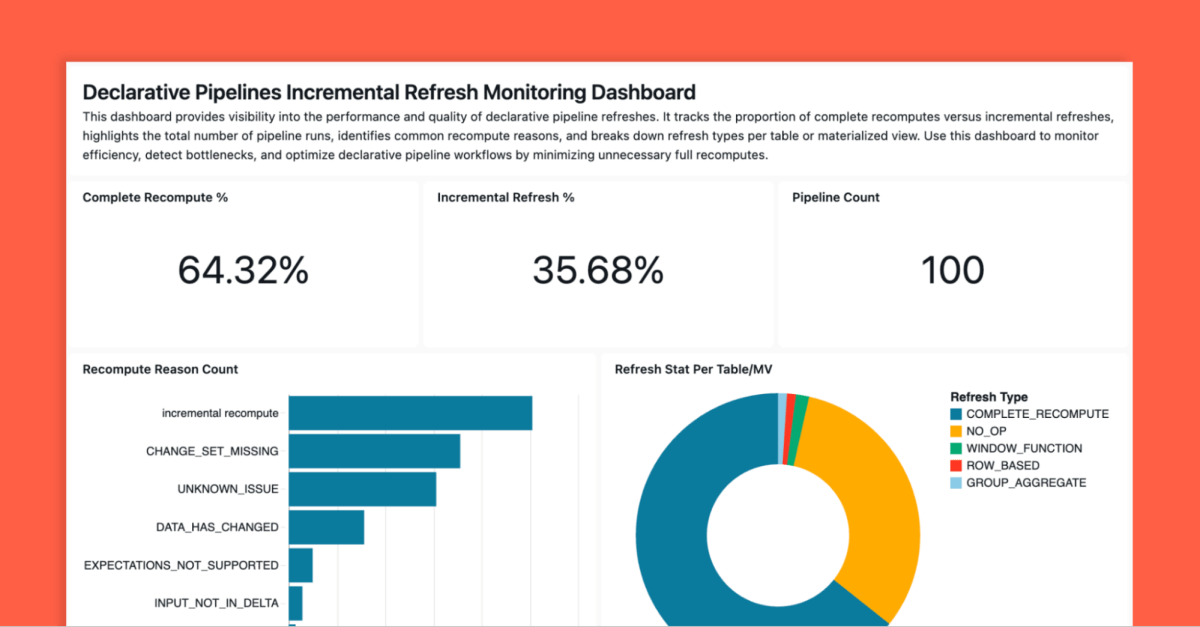

优化物化视图的重新计算

Databricks

·

通过视图渲染器V2提升iOS上会话重放的性能

Sentry Blog

·

Grafana 12.1 发布:为您的 Grafana 实例提供自动健康检查,优化 Grafana 警报视图,数据可视化更新等

engineering on Grafana Labs

·

/w_900,c_fit,co_rgb:232129,g_north_west,x_70,y_540,l_text:ubuntu_38:%40stefanjudis/stefan-judis-website/social-image-with-new-dude)