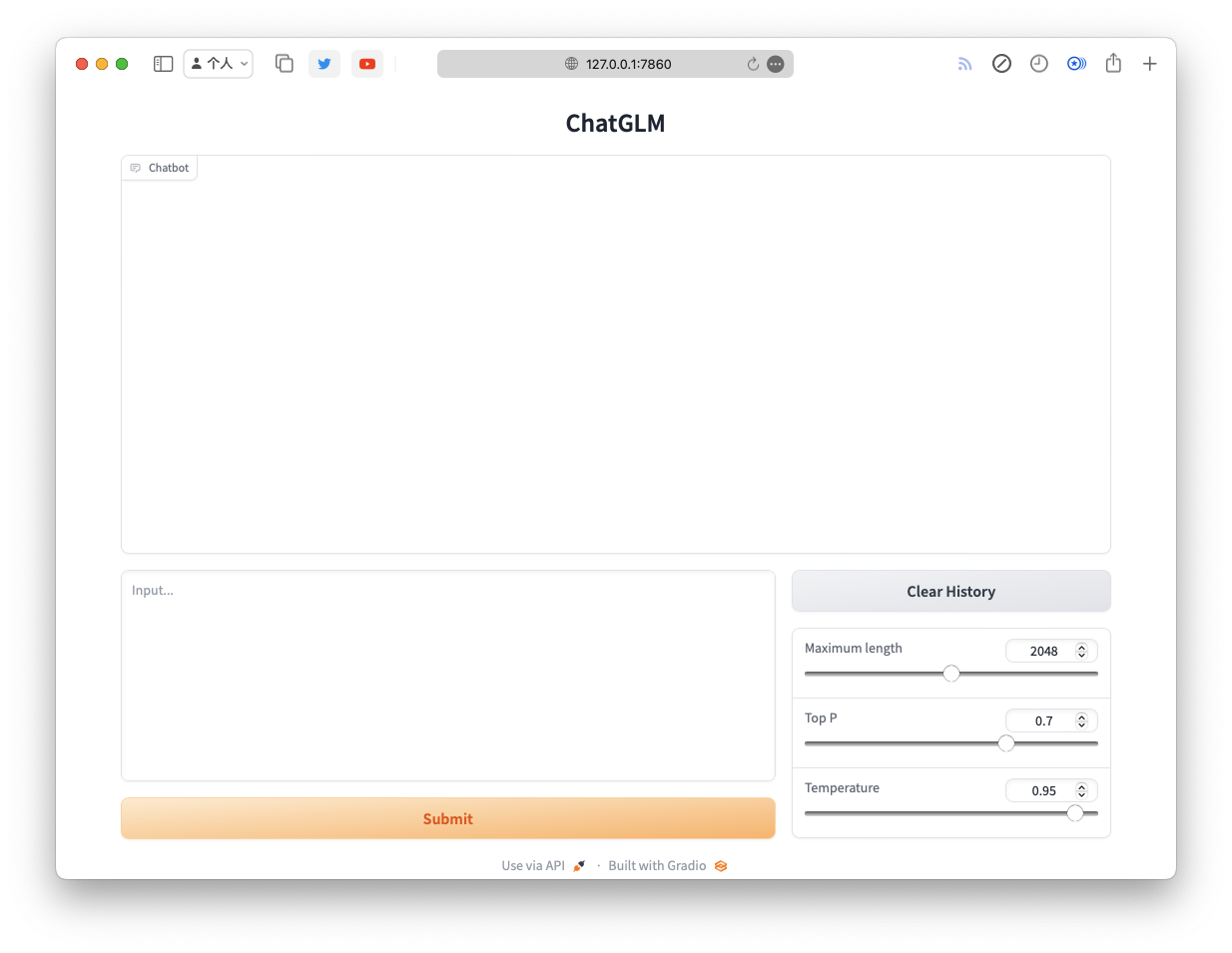

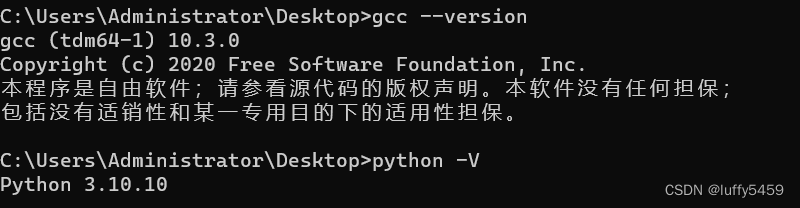

Mac本地RAG文档问答——Llama2 & ChatGLM3(量化版) & Ollama

Anjhon’s Blog

·

LLaMA2 VS ChatGLM,开源激战不止

AI.News

·

LLaMA2 VS ChatGLM,开源激战不止

AI.News

·