Llama.cpp 和 GGUF 中的多模态嵌入

Jina AI

·

使用 llama.cpp 构建 AI 代理

KDnuggets

·

Building a RAG Pipeline with llama.cpp in Python

MachineLearningMastery.com

·

无法加载共享库 'llama.dll': 找不到 (llama-cpp-python)

DEV Community

·

用 Ollama?其實你在跑 llama.cpp!學會直接使用它,發揮更強性能!

DEV Community

·

Jan v0.5.15:对llama.cpp设置的更多控制、先进的硬件控制及更多功能

DEV Community

·

SGLang与Llama.cpp的快速速度测试

DEV Community

·

使用OpenWebUI和Llama.cpp实现DeepSeek-R1工具调用以构建本地AI工作流程

DEV Community

·

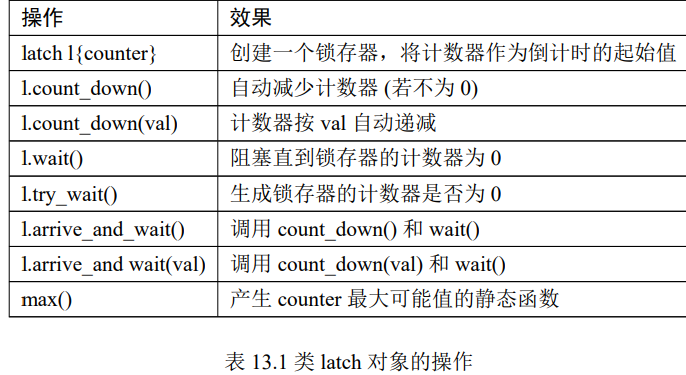

现代cpp多线程与并发初探

Sekyoro的博客小屋

·

llama.cpp:CPU与GPU、共享VRAM与推理速度

DEV Community

·