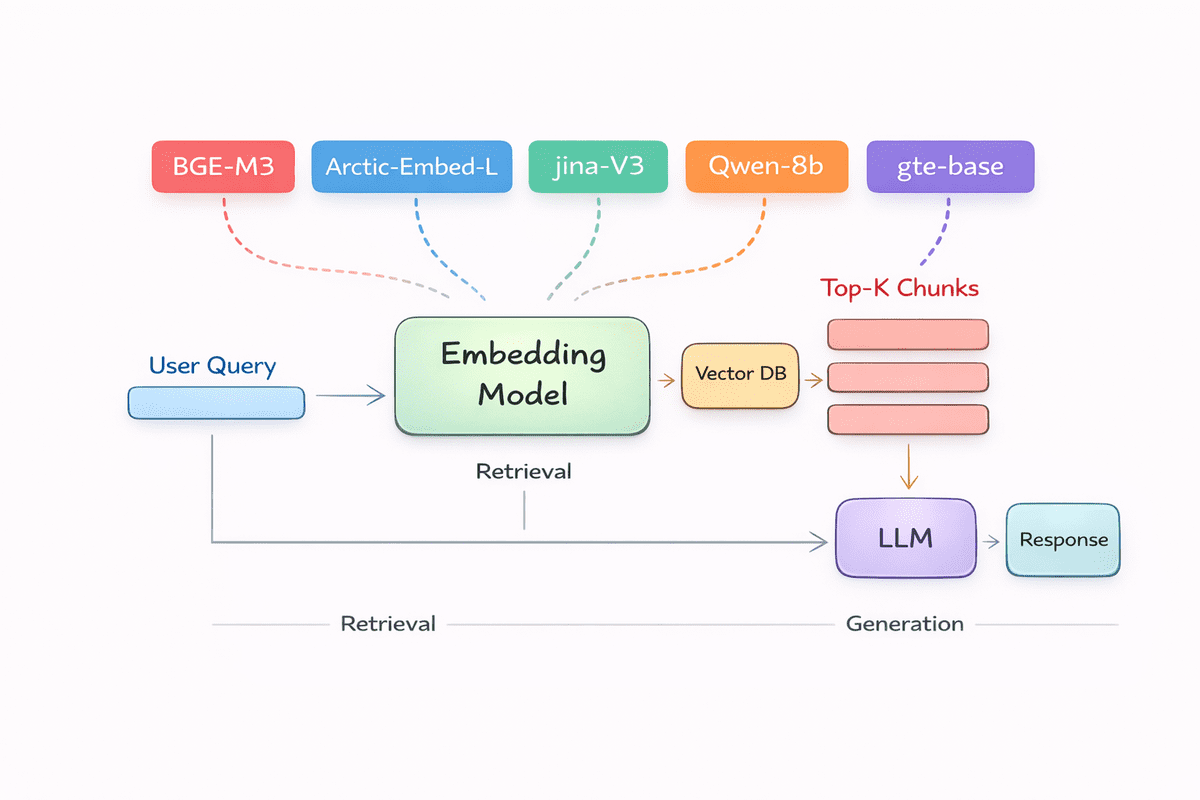

适用于您的RAG管道的五大嵌入模型

KDnuggets

·

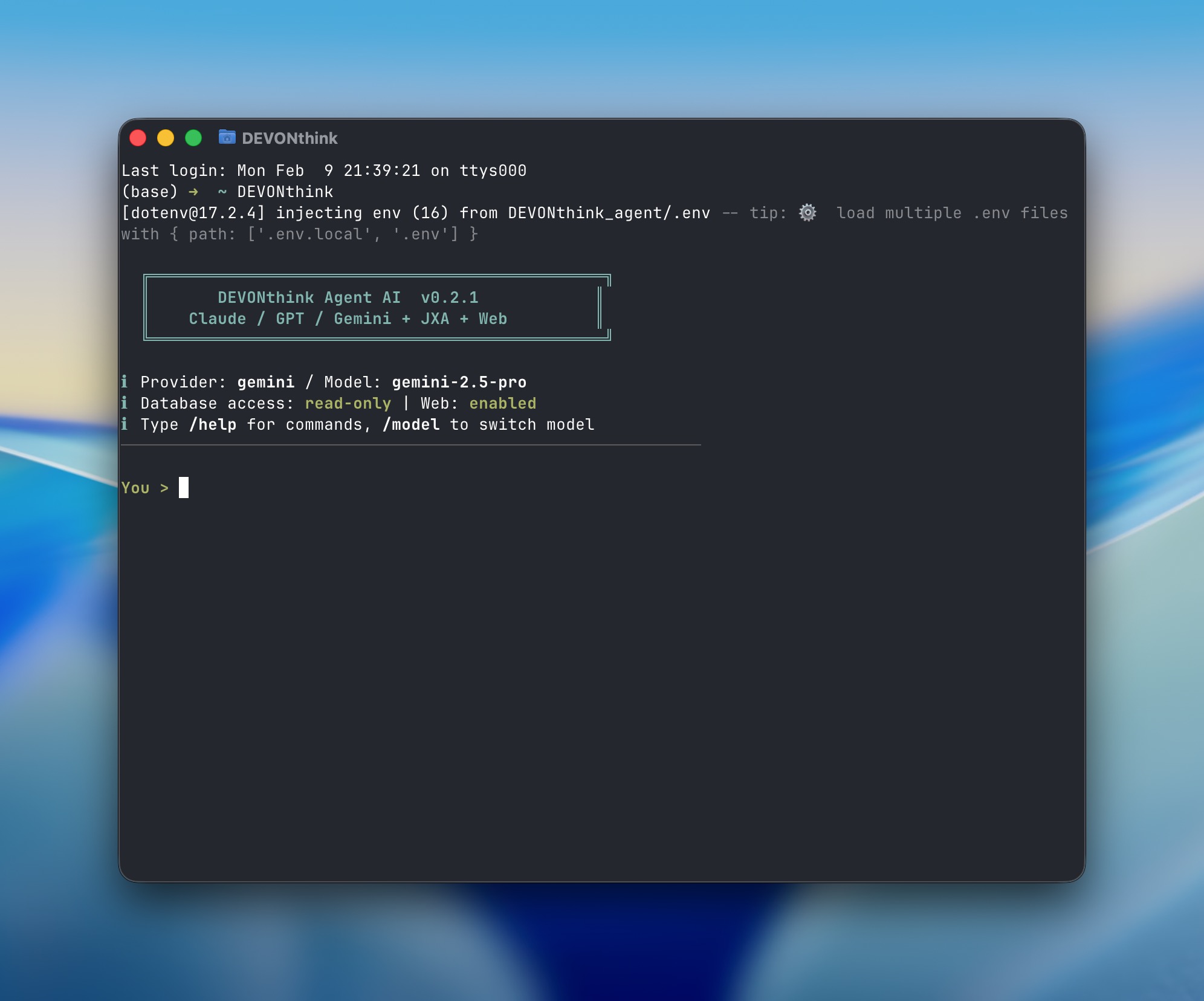

DEVONthink Agent: a CLI tool with RAG-enhanced search

Another Dayu

·

![AI大模型RAG项目实战课-Java版本[完结无密]](https://www.dqzboy.com/wp-content/uploads/2022/08/1660652165-04c17740b9e647d.png)

AI大模型RAG项目实战课-Java版本[完结无密]

浅时光博客

·

如何使用Next.js、Supabase和OpenAI构建一个AI驱动的RAG搜索应用

freeCodeCamp.org

·

RAG并未消亡,但上下文工程是新的热门趋势

The New Stack

·

学习RAG与MCP基础知识

freeCodeCamp.org

·