Salesforce AI Research 推出 BLIP-3-Video:用于视频的多模态语言模型,旨在有效捕捉多帧的时间信息

原文中文,约2000字,阅读约需5分钟。发表于:。视觉语言模型(VLM)因其整合视觉和文本数据的能力而在人工智能领域日益突出。这些模型在视频理解、人机交互和多媒体应用等领域发挥着至关重要的作用,提供了根据视频输入回答问题、生成字幕...

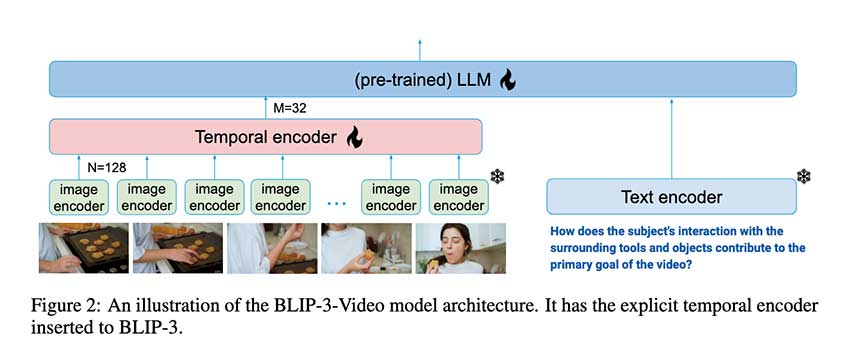

视觉语言模型(VLM)在视频理解中变得越来越重要,特别是BLIP-3-Video模型通过引入时间编码器显著提升了视频处理效率。该模型将视觉标记数量减少至16-32个,保持高准确率并降低计算开销,适用于复杂视频任务,推动了AI在各行业的应用。