💡

原文英文,约500词,阅读约需2分钟。

📝

内容提要

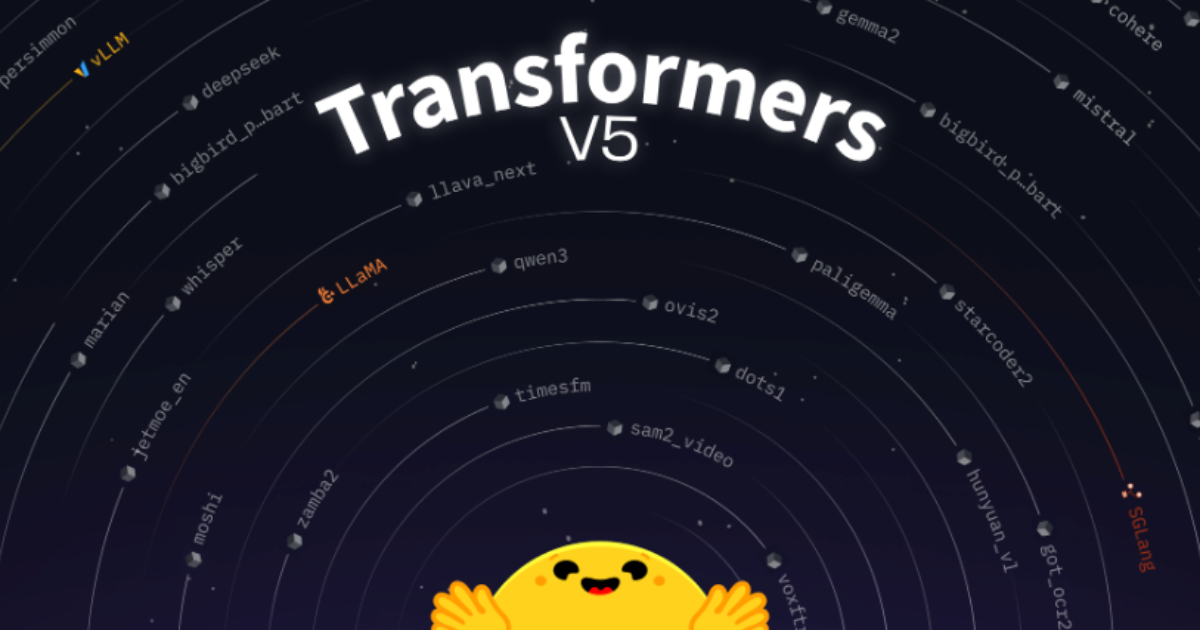

Hugging Face发布了Transformers v5的首个候选版本,强调互操作性和简化,采用模块化架构,主要支持PyTorch。新增的“transformers serve”组件便于模型部署,量化成为重要概念,旨在巩固Transformers作为开放AI开发的基础设施。

🎯

关键要点

- Hugging Face发布了Transformers v5的首个候选版本,标志着该库的重要进步。

- Transformers v5的核心目标是互操作性,确保模型定义、训练工作流、推理引擎和部署目标能够无缝协作。

- 该版本强调简化,采用模块化架构,减少模型实现之间的重复,标准化常见组件。

- PyTorch成为主要框架,TensorFlow和Flax的支持被逐步淘汰,以实现更深层次的优化和清晰度。

- 扩展了对大规模预训练的支持,模型初始化和并行性进行了重构,以更好地与其他工具集成。

- 增强了推理功能,提供了简化的API、连续批处理和分页注意力。

- 引入了“transformers serve”组件,便于通过OpenAI兼容API部署模型。

- 量化成为一项重要概念,权重加载被重新设计以更自然地支持低精度格式。

- Transformers v5旨在巩固其作为开放AI开发基础设施的角色,通过标准化模型定义和与训练、推理、部署工具的紧密对接。

➡️