搭建 OpenClaw 并关联 Github Copilot,实现无限免费大模型 token

大象笔记 - Notes of Elephant Leg

·

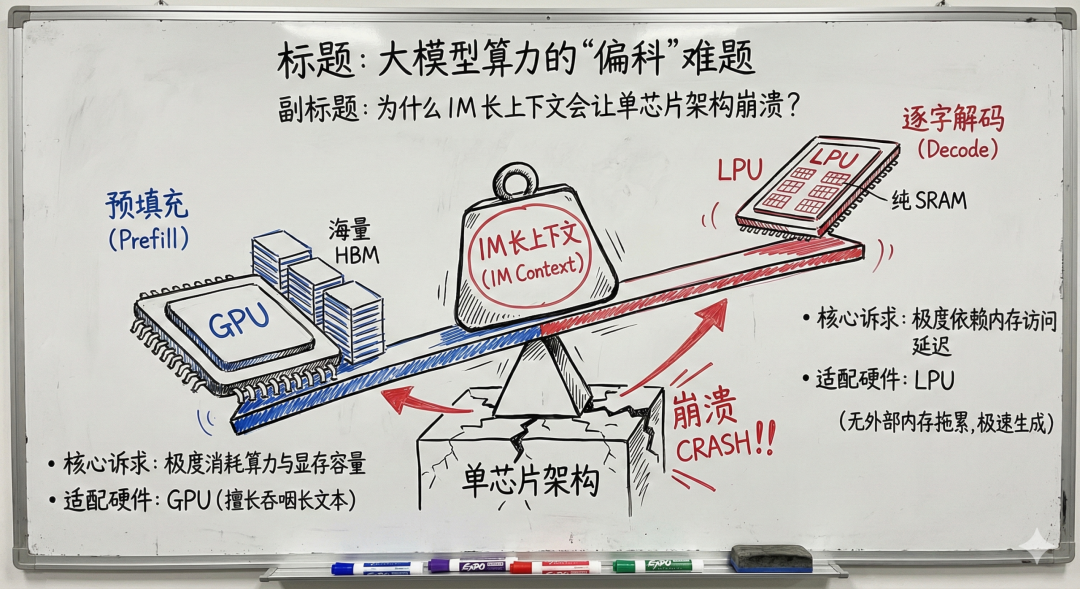

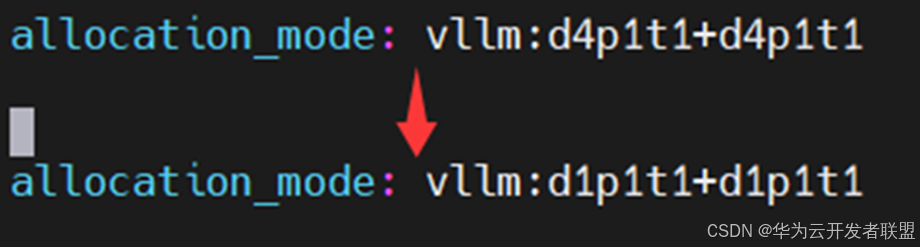

AReaL x 昇腾,加速大模型全异步RL训练创新

华为云官方博客

·

一分钟读论文:《文言文100%破解大模型,ICLR2026曝重大安全漏洞》

Micropaper

·

融合语言与智能:天津外国语大学与文心大模型的务实探索

百度大脑

·

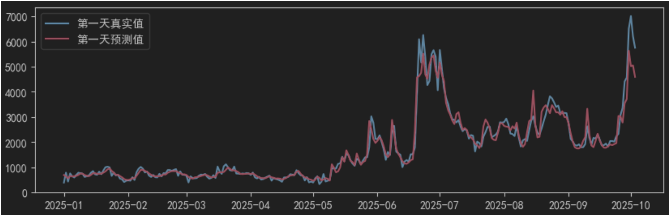

告别传统水情预测,文心大模型助桂冠电力破解水力发电难题

百度大脑

·

华为全面升级银行AI与大模型解决方案

全球TMT-美通国际

·

阿里千问大模型换将,32岁林俊旸官宣告别

量子位

·