标签

编码器

相关的文章:探索最新的编码器技术与应用,包括自编码器、视频编码器及多模态模型,了解其在人工智能领域的创新与发展。

机器之心 ·

T5Gemma 2是基于Gemma 3的多模态长上下文编码器-解码器模型,采用绑定词嵌入和合并注意力机制,显著减少参数量。它支持图像与文本处理,具备更大的上下文窗口和多语言能力,适合快速实验和应用。

The Keyword ·

实时互动网 ·

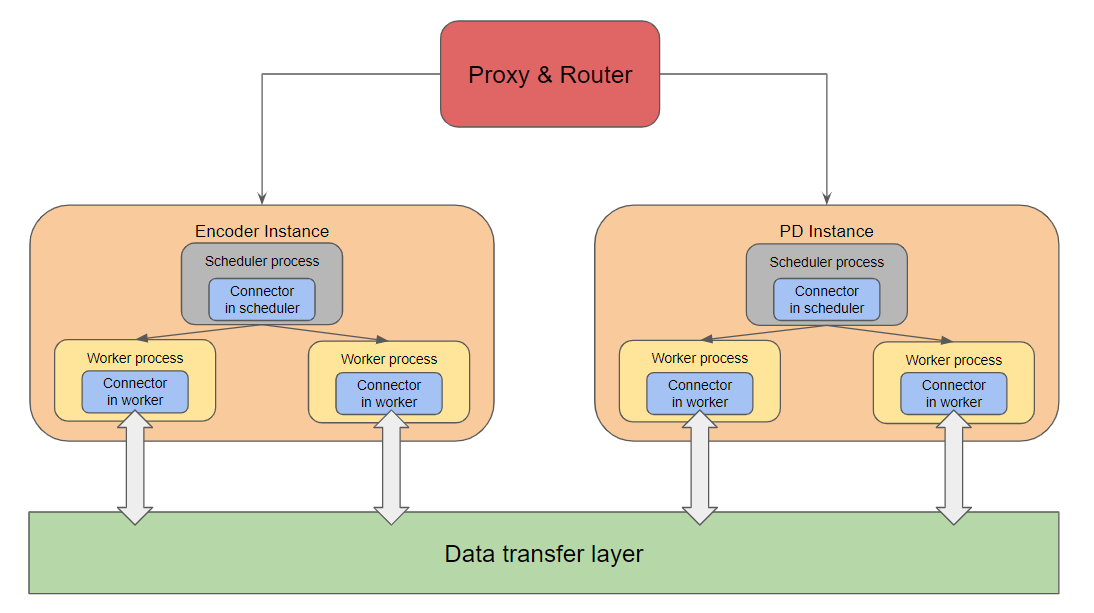

vLLM Blog ·

Seraphineの小窝 ·

Apple Machine Learning Research ·

实时互动网 ·

实时互动网 ·

实时互动网 ·

PaddleSpeech是基于飞桨的开源语音项目,最新发布的1.5.0版本适配飞桨3.0,新增DAC模型支持和AudioTools模块,优化了音频处理功能和损失函数,提高了模型的准确性和易用性。

实时互动网 ·

本研究提出了一种稀疏自编码器去噪概念向量(SDCV),有效解决大语言模型中的噪声问题,提高了现有方法的成功率,并通过实验验证了其对模型鲁棒性的影响。

BriefGPT - AI 论文速递 ·