ParaRNN:解锁非线性RNN的大规模语言模型的并行训练

Apple Machine Learning Research

·

数据质量的幻觉:重新思考基于分类器的质量过滤在大规模语言模型预训练中的应用

Apple Machine Learning Research

·

语言模型微调的温和介绍

MachineLearningMastery.com

·

叙事轨迹:超越画面的评估视频语言模型

Apple Machine Learning Research

·

评估语言模型的困惑度

MachineLearningMastery.com

·

经济实惠地托管语言模型

KDnuggets

·

Ai2 推出 Molmo 2 开源视频语言模型

实时互动网

·

变换器的思维方式:驱动语言模型运作的信息流

KDnuggets

·

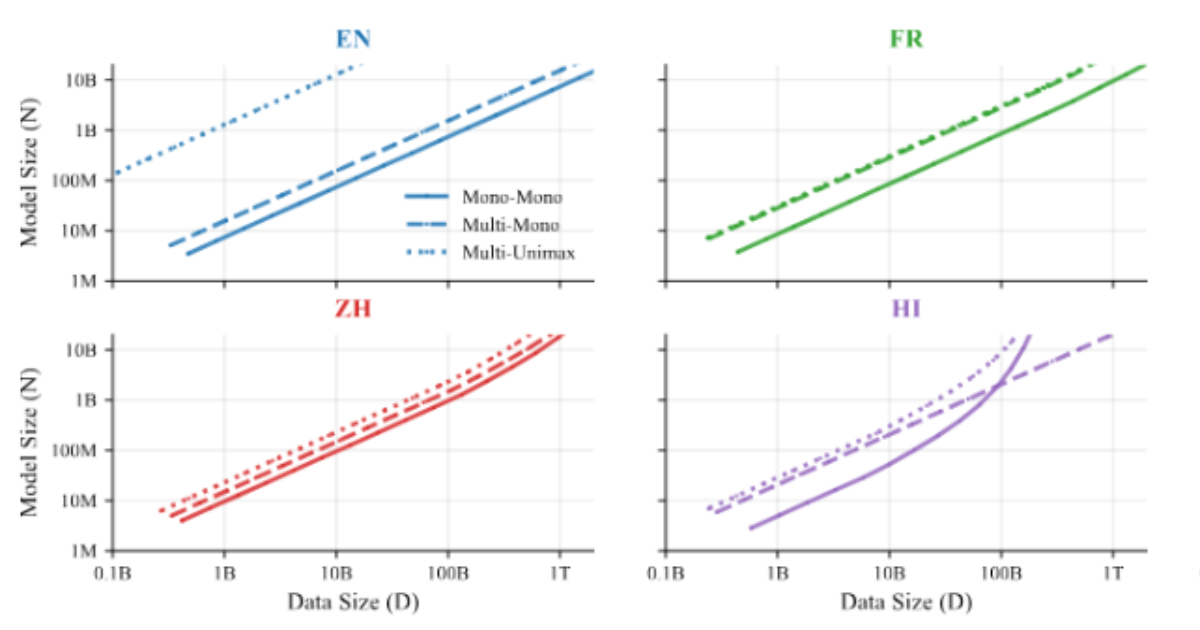

评估数据质量在训练双语语言模型中的作用

Apple Machine Learning Research

·

GRACE:可解释的逆强化学习语言模型框架

Apple Machine Learning Research

·

大规模语言模型工作负载的令牌高效数据准备指南

The New Stack

·