💡

原文中文,约4600字,阅读约需11分钟。

📝

内容提要

本文介绍了在Windows下配置Spark访问Hive的步骤,以及使用SparkSession和HiveContext读写Hive数据的方法。同时提到了在IDE环境中配置Python开发环境的步骤。

🎯

关键要点

- 在Windows下配置Spark访问Hive的步骤

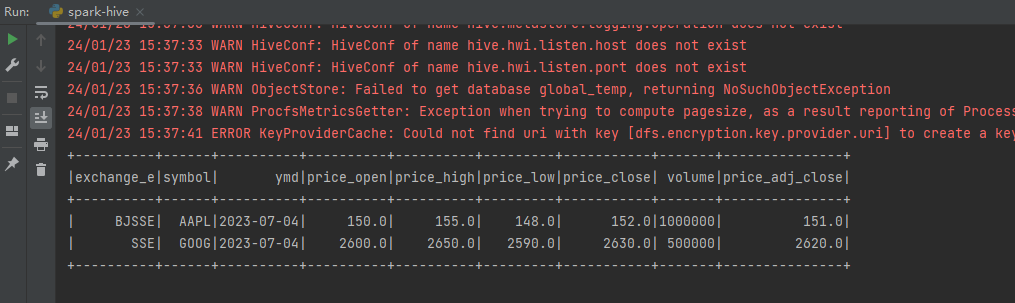

- 检查PySpark和Hive环境是否正常运行

- 将Hive配置文件拷贝到Spark配置目录

- 拷贝MySQL连接驱动Jar包到Spark的jars目录

- 在IDE中配置PySpark开发环境

- 使用SparkSession和HiveContext读写Hive数据

- 从Spark 2.0开始使用SparkSession作为主要接口

- 使用SQLContext和HiveContext读取Hive数据

- 使用SparkSession读取和写入Hive表

- Hive 3.0后默认表格式为ORC,支持行级事务操作

➡️