💡

原文中文,约8400字,阅读约需20分钟。

📝

内容提要

本文介绍了基于Spark和Python的B站数据处理与分析实验,包括环境搭建、Hadoop和Spark安装、数据采集及代码组织,强调了AI工具在编程中的应用。

🎯

关键要点

- 文章介绍了基于Spark和Python的B站数据处理与分析实验。

- 实验环境包括MacBook Air、Ubuntu 22.04、Hadoop 3.3.5、Spark 3.4.0等。

- 详细描述了在VMWare中安装Ubuntu的步骤。

- 提供了Hadoop和Spark的安装过程及注意事项。

- 数据采集部分使用了ChatGPT辅助选择数据集和编写代码。

- 采集代码结构清晰,包含多个模块和数据存储目录。

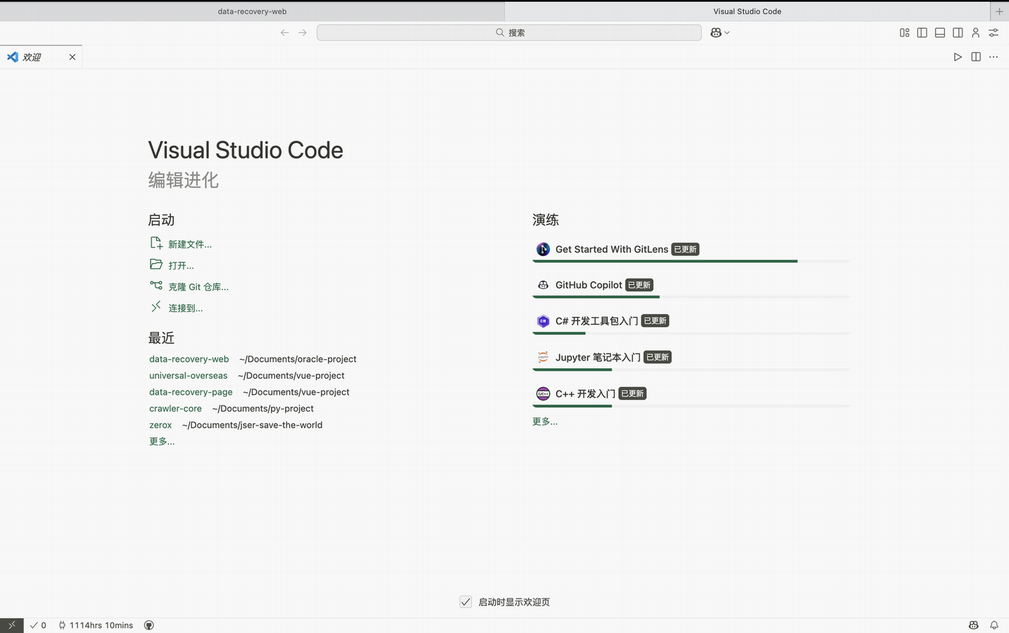

- 使用AI工具如Copilot和ChatGPT辅助编写爬虫代码。

- 数据预处理阶段筛选了有用字段并进行了初步处理。

➡️