💡

原文英文,约1100词,阅读约需4分钟。

📝

内容提要

DeepEval是一个开源Python库,用于评估各种LLM应用,提供50多种度量标准。结合LlamaIndex框架,用户可以构建复杂的RAG管道,通过定义答案相关性、忠实度和上下文精度等度量标准,优化模型性能并进行有效评估。

🎯

关键要点

- DeepEval是一个开源Python库,用于评估各种LLM应用,提供50多种度量标准。

- 结合LlamaIndex框架,用户可以构建复杂的RAG管道。

- DeepEval提供自定义度量标准构建器,便于评估特定领域的应用。

- LlamaIndex允许构建强大的RAG管道,支持文本和多模态应用。

- 评估需要安装DeepEval和LlamaIndex。

- DeepEval的度量标准包括答案相关性、忠实度和上下文精度。

- 答案相关性衡量LLM应用输出与用户输入的相关性。

- 忠实度衡量LLM输出与检索上下文内容的一致性。

- 上下文精度评估最相关的信息块是否优先排序。

- RAG管道主要由检索器和生成器组成。

- 每个度量标准受到管道中不同参数的独特影响。

- 设置RAG应用时,使用VectorStoreIndex加载知识库文档。

- 创建测试用例以捕捉模型输出和检索上下文。

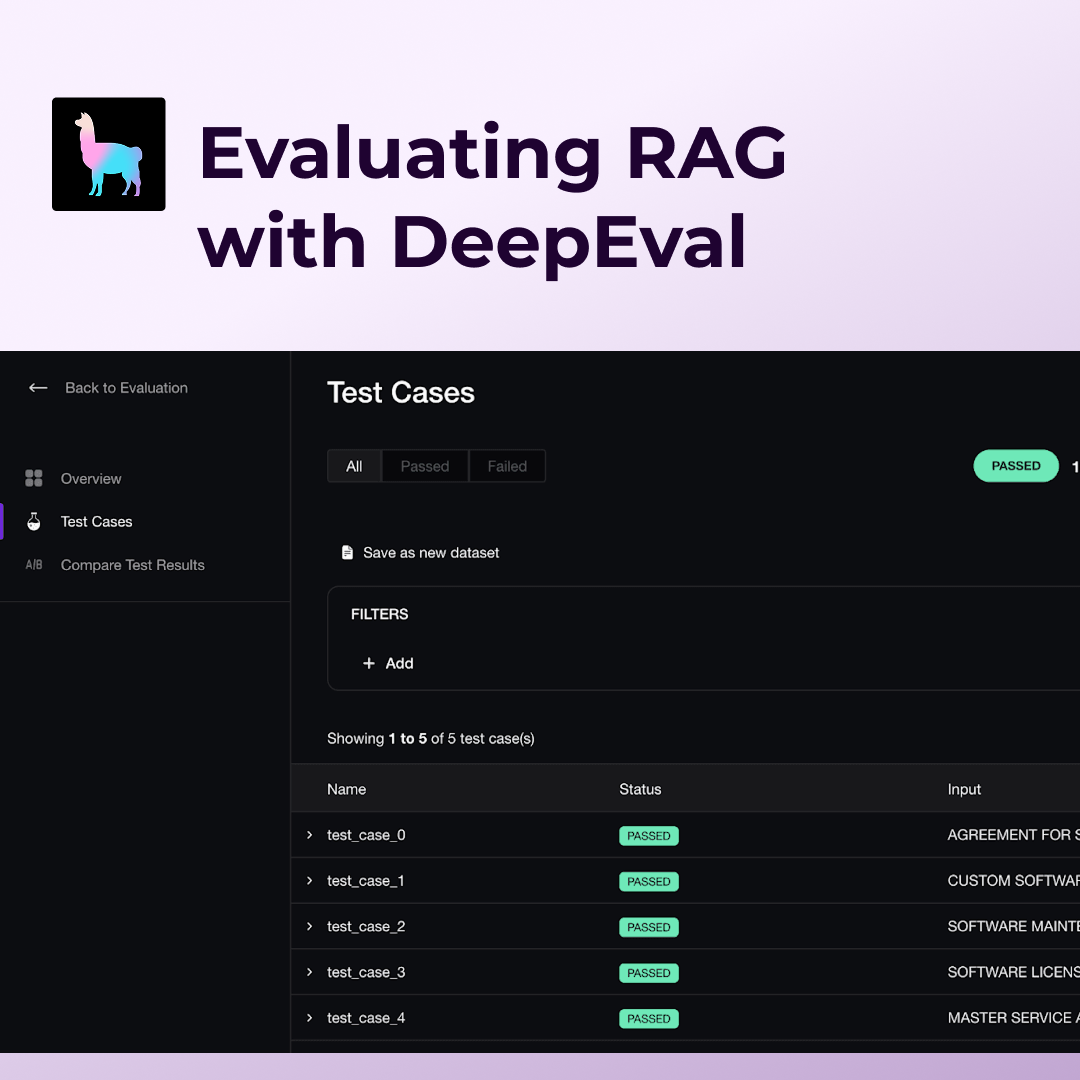

- 运行评估只需将测试用例和度量标准传入evaluate函数。

- 低忠实度分数表明模型未能很好地基于检索上下文提供答案。

- 可以通过实验不同模型来改善RAG性能。

- DeepEval支持标准RAG度量和自定义度量。

- Confident AI提供云端评估和深入分析工具。

➡️