💡

原文中文,约1800字,阅读约需5分钟。

📝

内容提要

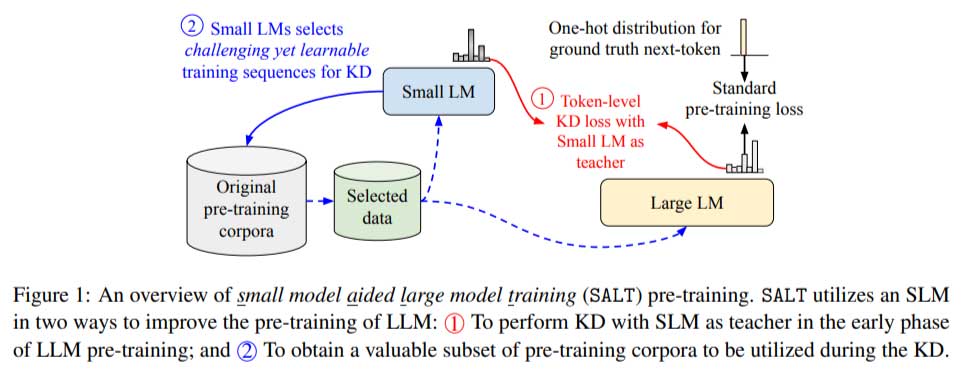

大型语言模型(LLM)在对话代理和内容创建中至关重要,但训练成本高。谷歌研究院提出SALT方法,通过小型模型(SLM)辅助LLM训练,降低计算需求28%,提升模型质量。SALT采用两阶段流程,初期利用SLM指导LLM,后期进行自监督学习,确保LLM专注于高价值数据,为资源有限的机构提供新的训练思路。

🎯

关键要点

- 大型语言模型(LLM)在对话代理和内容创建中至关重要,但训练成本高。

- 谷歌研究院提出SALT方法,通过小型模型(SLM)辅助LLM训练,降低计算需求28%,提升模型质量。

- SALT采用两阶段流程,初期利用SLM指导LLM,后期进行自监督学习。

- SALT确保LLM专注于高价值数据,提供新的训练思路,尤其适合资源有限的机构。

- 实验结果显示,使用SALT训练的模型在多个基准测试中表现优于传统方法。

- SALT通过选择具有挑战性的数据,加快学习速度而不影响质量。

- 经过监督微调后,SALT训练的模型在小样本评估和下游任务中表现出更好的泛化能力。

- SALT重新定义了LLM训练的范式,实现了效率和有效性的平衡,推动AI技术的民主化。

➡️