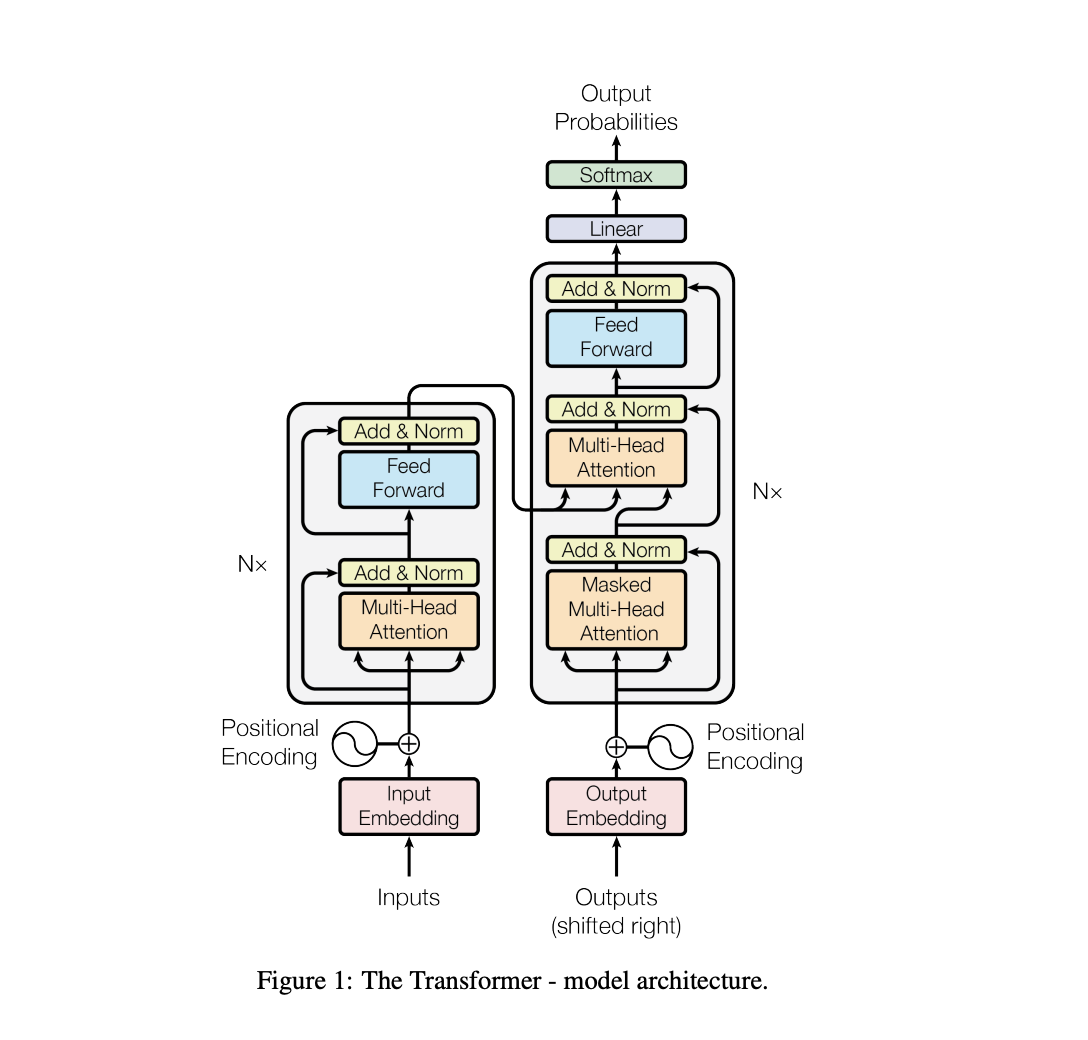

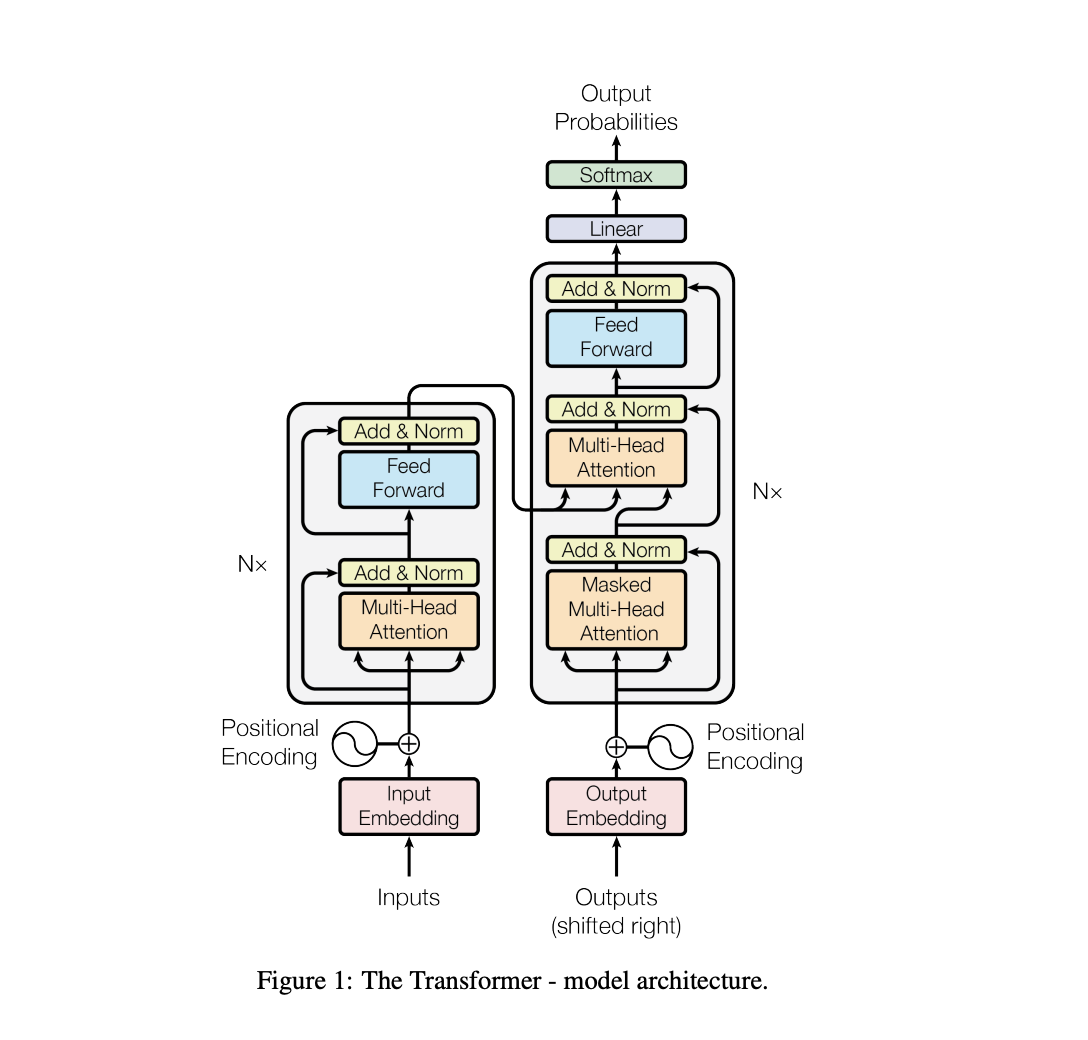

ChatGPT使用的Transfomer模型

本文介绍了Transformer模型在LLAMA中的应用,包括网络结构、注意力机制和实现细节。同时提到使用ChatGPT辅助理解代码和问题,并计划在后续文章中分享更多关于ChatGPT技术原理的内容。

原文中文,约17000字,阅读约需41分钟。

本文介绍了Transformer模型在LLAMA中的应用,包括网络结构、注意力机制和实现细节。同时提到使用ChatGPT辅助理解代码和问题,并计划在后续文章中分享更多关于ChatGPT技术原理的内容。