💡

原文英文,约900词,阅读约需4分钟。

📝

内容提要

本文介绍了如何在Google Colab上使用LLaMA C++库运行Mixtral 8x7b模型,以最大化计算要求下的质量输出。Mixtral 8x7b是由Mistral AI创建的高质量稀疏专家混合(SMoE)模型,具有开放权重,超越了大多数基准测试中的Llama 2 70B,并且推理速度快6倍。Mixtral在大多数标准基准测试中与GPT3.5相媲美,是成本/性能方面最佳的开放权重模型。Mixtral 8x7B模型在处理32k个标记的广泛上下文方面表现出色,并支持多种语言。LLaMA.cpp是一个C/C++库,提供了基于Facebook的LLM架构的高性能接口,可用于文本生成、翻译和问答等任务。LLaMA.cpp支持多种LLM,包括LLaMA、LLaMA 2、Falcon、Alpaca、Mistral 7B、Mixtral 8x7B和GPT4ALL。它与所有操作系统兼容,并且可以在CPU和GPU上运行。

🎯

关键要点

- 本文介绍了如何在Google Colab上使用LLaMA C++库运行Mixtral 8x7b模型。

- Mixtral 8x7b是由Mistral AI创建的高质量稀疏专家混合模型,具有开放权重。

- Mixtral 8x7b在大多数基准测试中超越Llama 2 70B,推理速度快6倍。

- 该模型在处理32k个标记的广泛上下文方面表现出色,支持多种语言。

- LLaMA.cpp是一个高性能的C/C++库,支持多种大型语言模型,包括Mixtral 8x7B。

- LLaMA.cpp可以在所有操作系统上运行,并支持CPU和GPU。

- 使用命令行下载LLaMA.cpp GitHub库并安装。

- 从Hugging Face Hub下载Mixtral 8x7b模型文件。

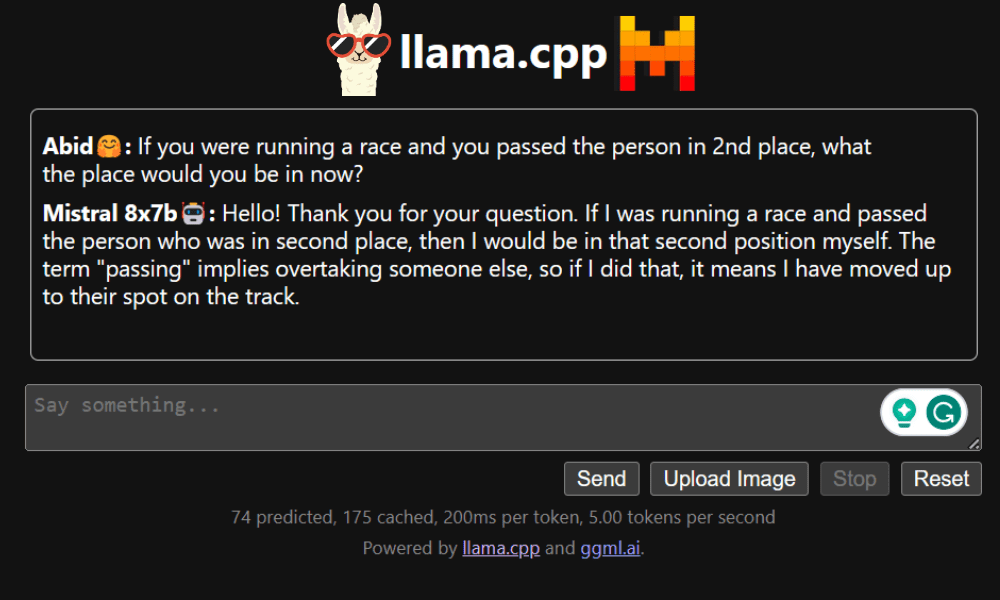

- 在Colab中运行LLaMA C++服务器并获取访问链接。

- 用户可以自定义聊天应用程序并与模型进行交互。

- Mixtral 8x7b提供优越的性能和效率,适合资源有限的用户实验大型语言模型。

➡️