💡

原文中文,约14400字,阅读约需35分钟。

📝

内容提要

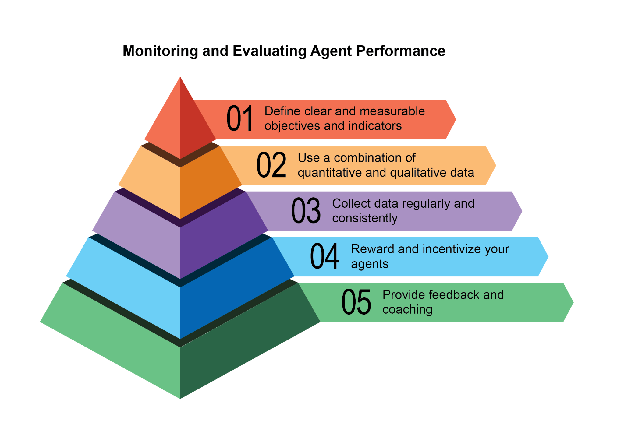

本章讨论智能代理的性能评估方法,包括监控目标进展、异常检测和反馈循环。重点在实时系统的性能跟踪、A/B 测试、合规审计和行为异常检测。通过定义指标和实施报告系统,确保代理在操作环境中的有效性和合规性。

🎯

关键要点

- 本章探讨智能代理的性能评估方法,包括监控目标进展和异常检测。

- 重点在实时系统的性能跟踪、A/B 测试、合规审计和行为异常检测。

- 通过定义指标和实施报告系统,确保代理在操作环境中的有效性和合规性。

- 实时系统中的性能跟踪涉及监控代理的准确性、延迟和资源消耗。

- A/B 测试用于系统地比较不同代理版本或策略的性能。

- 合规性审计生成自动化报告,跟踪代理遵守道德和安全协议的情况。

- 漂移检测监控代理输出的相关性或准确性,以识别性能退化。

- 异常检测识别代理的意外操作,可能表明错误或恶意攻击。

- 学习进度评估跟踪代理的学习曲线和泛化能力。

- 评估代理的响应准确性是核心过程,涉及确定输出的相关性和正确性。

- 延迟监控对代理操作的速度至关重要,需记录到持久存储系统。

- 跟踪 LLM 交互的 token 使用量有助于管理成本和优化资源分配。

- 使用 LLM 作为评估者的有用性指标提供细微的主观品质评估。

- 评估代理的轨迹对于理解推理过程和识别低效率至关重要。

- 多代理系统的评估需要关注团队合作和沟通的有效性。

- 承包商模型通过正式化合约和动态反馈提升代理的可靠性和可问责性。

- Google 的 ADK 提供结构化的评估方法,支持单元测试和集成测试。

- 有效评估 AI 代理需要持续的、多方面的评估,关注动态环境中的性能。

➡️