通过LLaMA代码分析,了解现代Transformer

原文中文,约16200字,阅读约需39分钟。发表于:。可以在notion阅读, 格式更好一些.

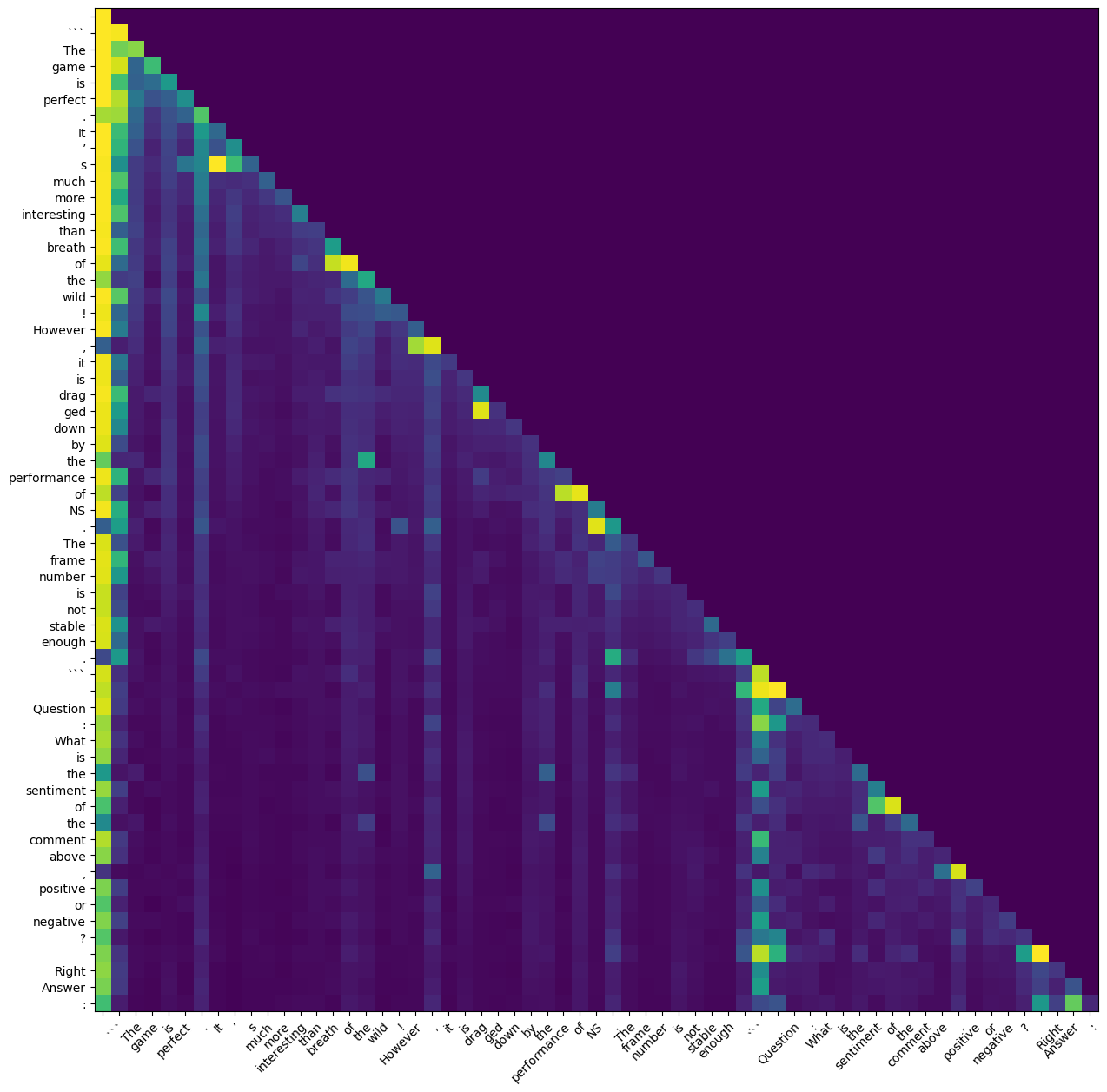

本文介绍了LLaMA模型的代码解析和实验结果,该模型是基于Transformer的语言模型,用于生成文本。文章详细解析了LLaMA的代码结构和特点,包括pre-normalization和Rotary Positional Embedding。同时,讨论了LLaMA在情感分析任务中的应用和使用score表示模型输出confidence的方法。最后,分析了Attention Weights的结果和未来的研究方向。