一分钟读论文:《AlphaEvolve - 用 LLM 自动发现多智能体学习算法》

Micropaper

·

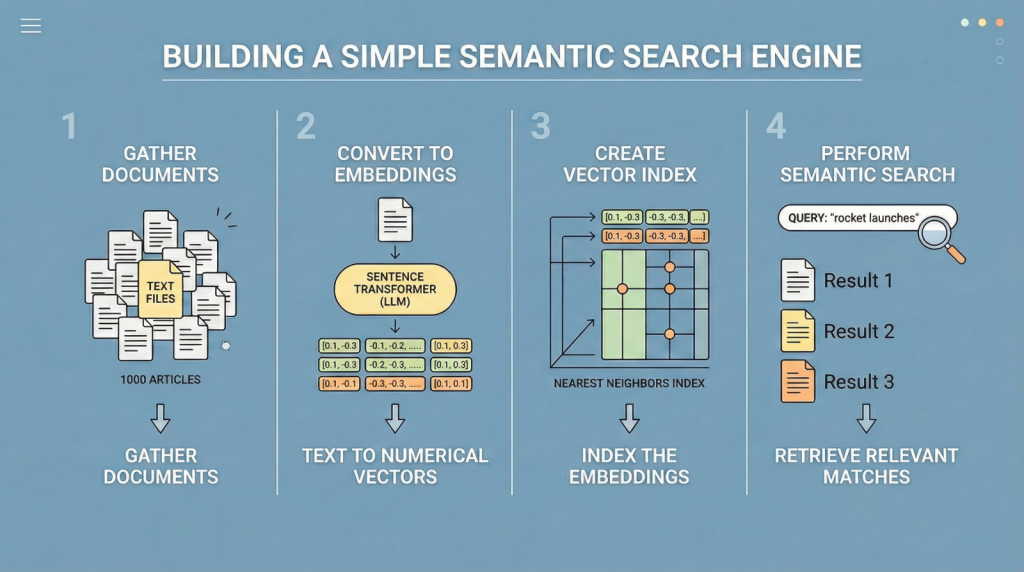

利用LLM嵌入构建语义搜索

MachineLearningMastery.com

·

ELM 架构突破:Modulate 用 100+ 个小模型打败 LLM,开启语音 AI 新时代

Micropaper

·

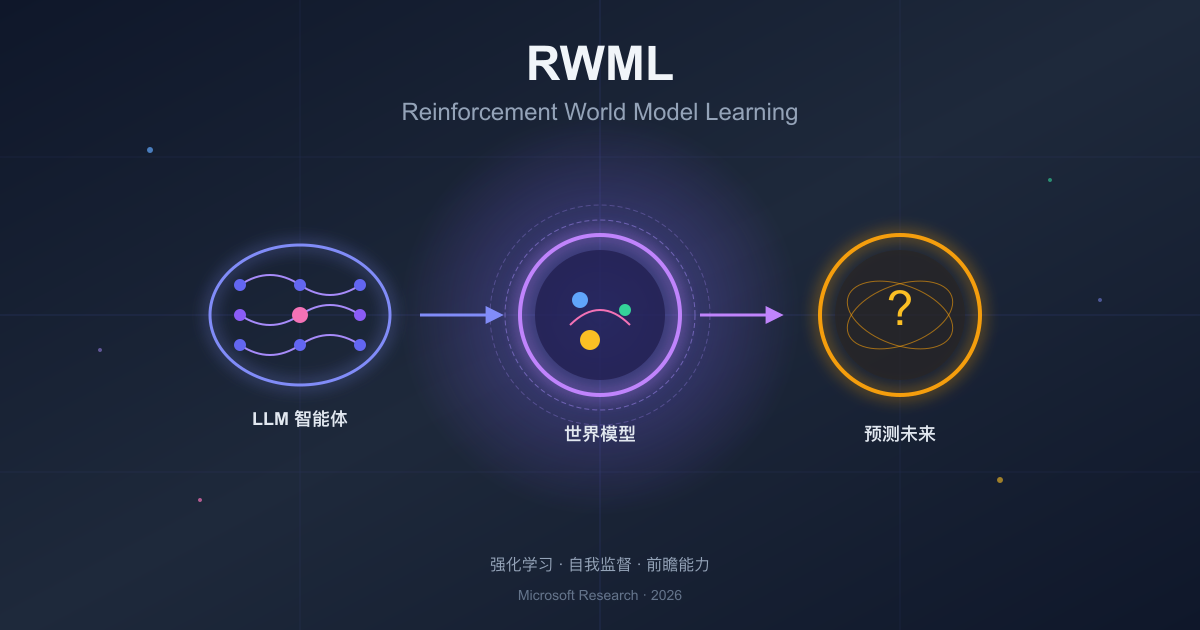

RWML:让 LLM 智能体学会预测未来——微软研究院突破性论文解读

Micropaper

·

Python源代码中的LLM使用

miguelgrinberg

·

新方法可能提高大型语言模型(LLM)的训练效率

MIT News - Artificial intelligence

·

如何使用LangChain、API和Streamlit构建LLM市场助手MVP

freeCodeCamp.org

·

在RubyMine中构建适合LLM的MCP工具:分页、过滤和错误设计

The JetBrains Blog

·

如何使用LangChain、API和Streamlit构建LLM市场助手MVP

freeCodeCamp.org

·

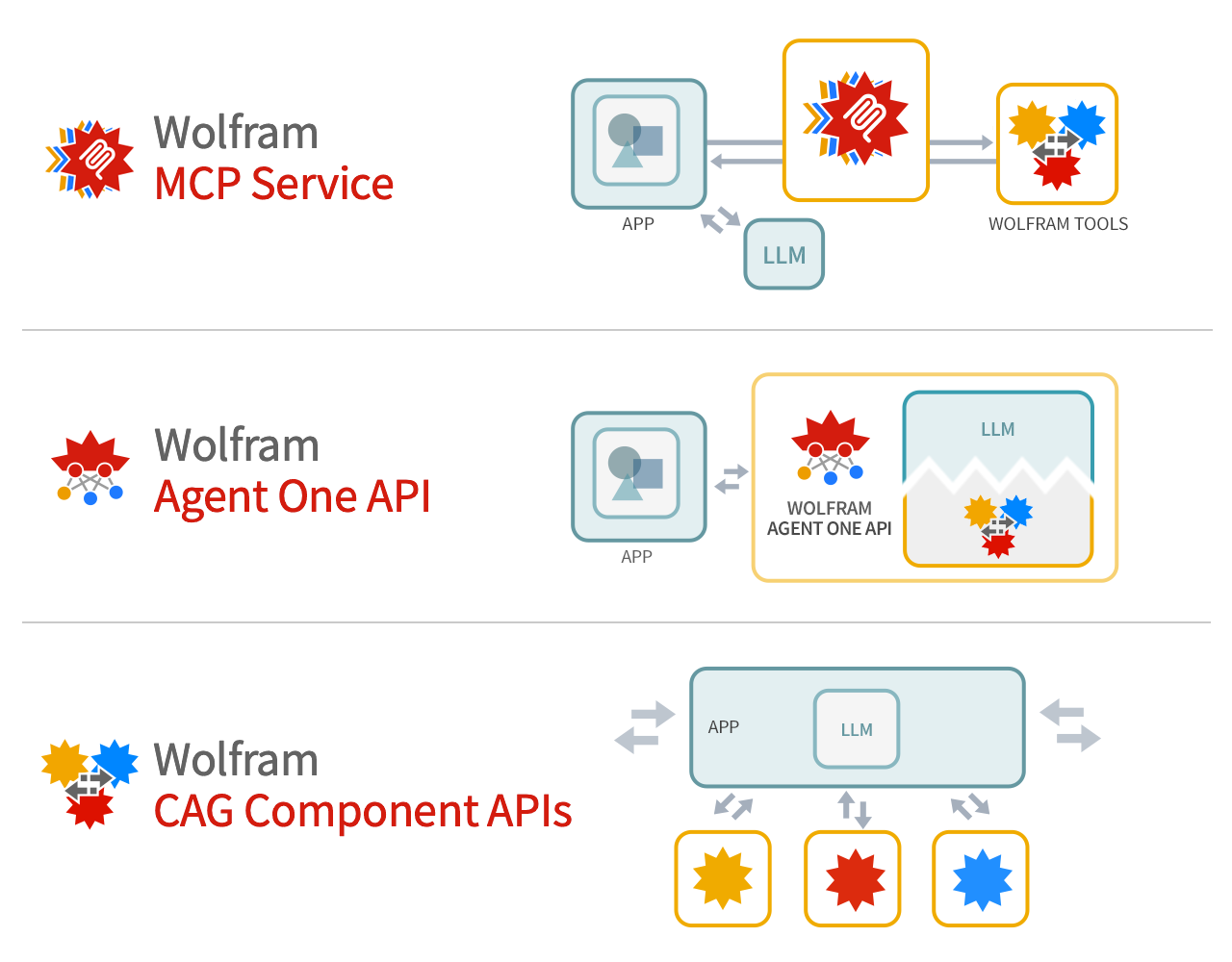

将Wolfram技术作为LLM系统的基础工具

Stephen Wolfram Writings

·

个性化功能可能使大型语言模型(LLM)变得更加迎合

MIT News - Artificial intelligence

·