💡

原文英文,约900词,阅读约需4分钟。

📝

内容提要

NVIDIA使用TensorRT-LLM软件将Hopper GPU在GPT-J LLM上的性能提升了近3倍。H200 GPU在MLPerf的最大生成AI测试中提供了最快的推理性能。NVIDIA还推出了具有更多内存的H200 GPU和GH200 Superchips。NVIDIA的Hopper GPU在MLPerf的每个AI推理测试中表现出色。NVIDIA展示了结构稀疏性、修剪和DeepCache等创新技术。MLPerf基准测试是透明客观的。

🎯

关键要点

- NVIDIA使用TensorRT-LLM软件将Hopper GPU在GPT-J LLM上的性能提升了近3倍。

- H200 GPU在MLPerf的最大生成AI测试中提供了最快的推理性能。

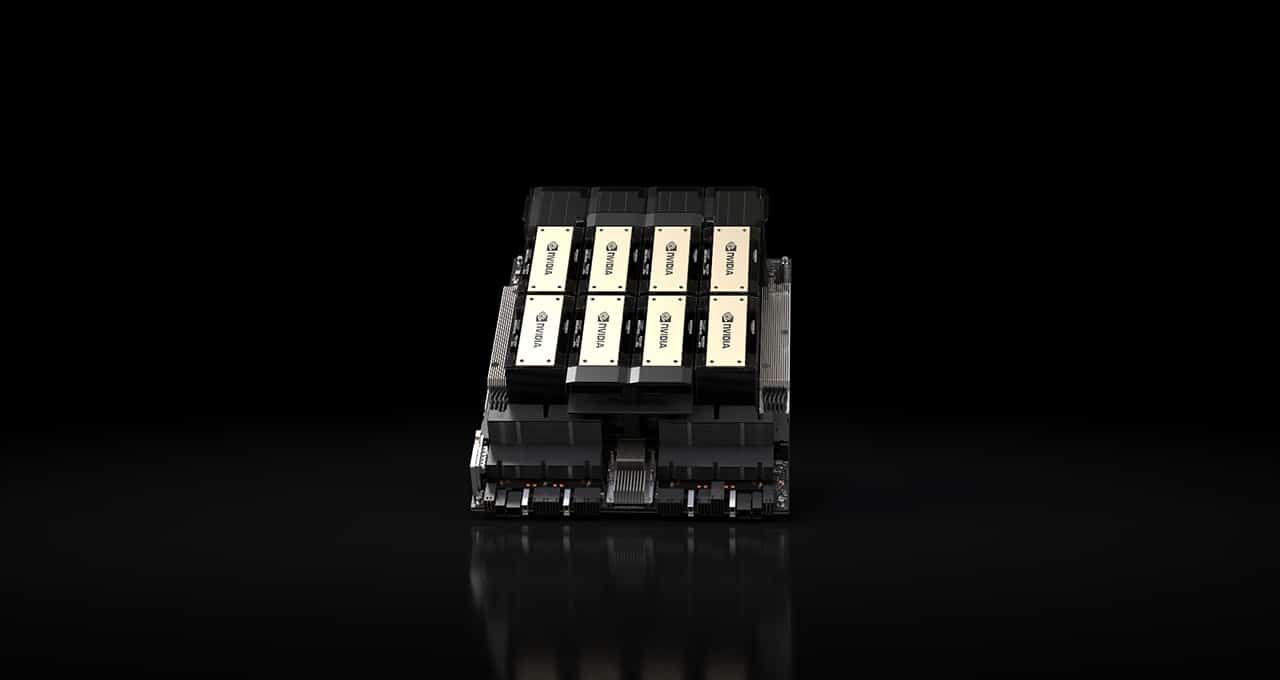

- NVIDIA推出了具有更多内存的H200 GPU和GH200 Superchips。

- H200 GPU在MLPerf的Llama 2基准测试中达到了每秒31,000个token的记录。

- H200 GPU配备141GB的HBM3e内存,速度比H100 GPU快43%。

- GH200 Superchips结合了Hopper架构GPU和NVIDIA Grace CPU,提供高达624GB的快速内存。

- Hopper GPU在最新的MLPerf基准测试中在每个AI推理测试中表现出色。

- NVIDIA展示了结构稀疏性、修剪和DeepCache等创新技术,分别提高了推理速度。

- MLPerf的测试是透明和客观的,用户可以依赖结果做出明智的购买决策。

- NVIDIA的合作伙伴参与MLPerf,以帮助客户评估AI系统和服务。

- NVIDIA Blackwell架构GPU将提供支持多万亿参数AI模型所需的新性能。

🏷️

标签

➡️