💡

原文英文,约2500词,阅读约需9分钟。

📝

内容提要

TPU(张量处理单元)是谷歌为深度学习设计的专用芯片,采用脉动阵列结构,显著提升计算效率。通过减少数据移动和优化矩阵运算,TPU解决了计算瓶颈,支持大规模语言模型的训练与推理。

🎯

关键要点

- TPU(张量处理单元)是谷歌为深度学习设计的专用芯片,显著提升计算效率。

- TPU通过减少数据移动和优化矩阵运算,解决了计算瓶颈,支持大规模语言模型的训练与推理。

- 谷歌的TPU家族自2015年以来经历了七代演变,从单芯片处理到9216芯片超级计算机。

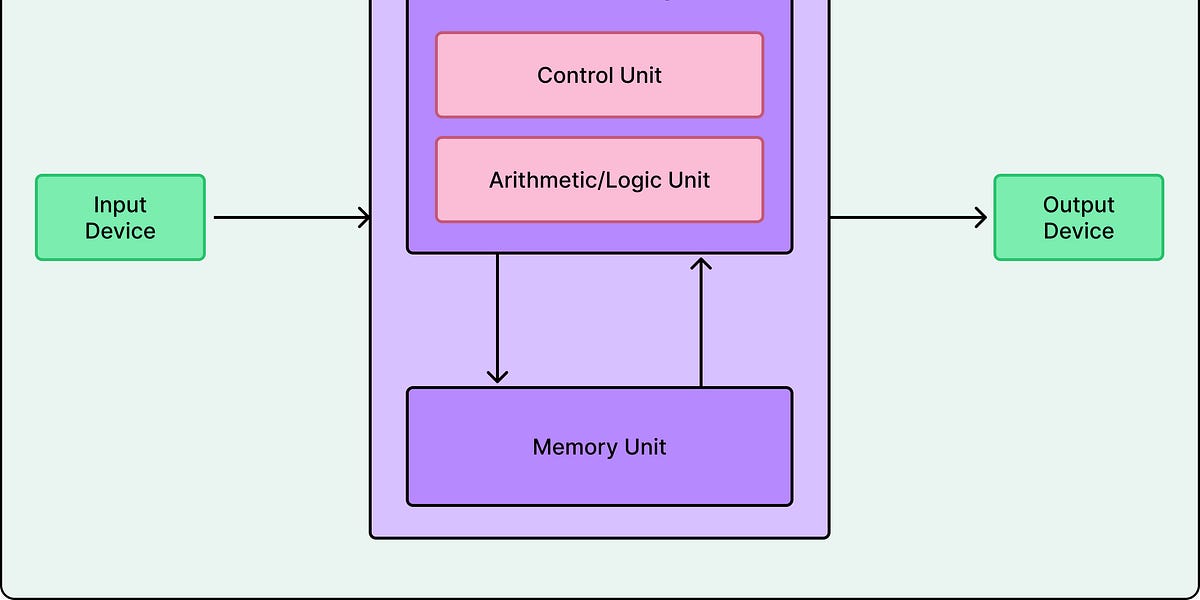

- 传统计算机遵循冯·诺依曼架构,导致数据传输瓶颈,TPU通过采用脉动阵列结构来解决这一问题。

- TPU的核心是脉动阵列架构,允许数据在芯片内以节能的方式流动。

- TPU的设计专注于神经网络所需的矩阵乘法,剥离了其他不必要的功能。

- TPU的矩阵乘法单元(MXU)和统一缓冲区等组件共同优化了数据处理效率。

- TPU通过量化使用低精度数字,显著提高了计算效率,减少了内存需求。

- TPU的发展历程显示出每一代在性能和能效上的提升,适应了AI硬件需求的变化。

- TPU在大规模语言模型训练和推理方面表现优异,但在某些情况下,GPU仍然是更好的选择。

- TPU代表了行业向特定领域加速器的转变,提供了比通用处理器更高的效率。

➡️