💡

原文英文,约500词,阅读约需2分钟。

📝

内容提要

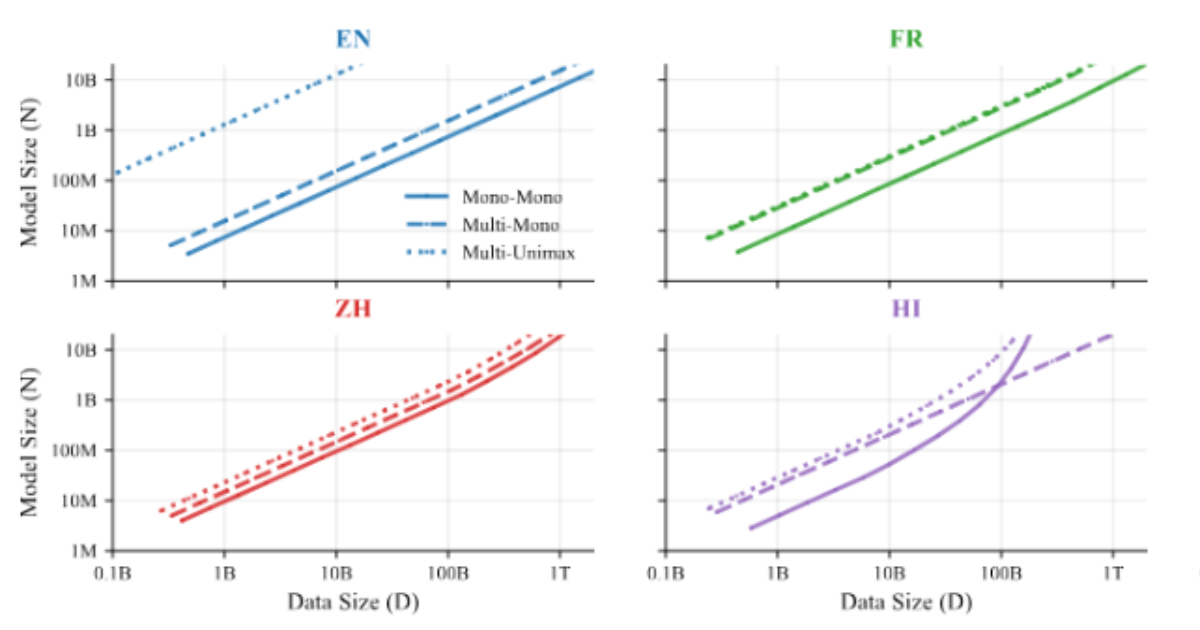

谷歌DeepMind研究人员推出ATLAS,探讨多语言模型的扩展规律,分析模型规模、训练数据与语言混合的相互作用。基于774次训练,ATLAS明确了跨语言迁移与多语言训练的效率权衡,发现增加语言数量会降低每种语言的性能,但积极的跨语言迁移可部分抵消这一影响。

🎯

关键要点

- 谷歌DeepMind研究人员推出ATLAS,探讨多语言模型的扩展规律。

- ATLAS分析模型规模、训练数据与语言混合的相互作用,基于774次训练。

- 现有的扩展规律主要基于单一语言训练,ATLAS扩展了这一研究,明确了跨语言迁移与多语言训练的效率权衡。

- ATLAS的核心是跨语言迁移矩阵,测量一种语言的训练如何影响另一种语言的性能。

- 积极的跨语言迁移与共享脚本和语言家族密切相关,某些语言组合表现出互惠效应。

- ATLAS量化了“多语言诅咒”,即随着语言数量增加,每种语言的性能下降。

- 实证结果显示,保持性能的前提下,增加语言数量需要相应增加模型规模和训练数据。

- 研究还探讨了从头开始预训练多语言模型与微调现有模型的有效性。

- 对于2B参数模型,预训练和微调的交叉点通常发生在144B到283B个token之间。

- ATLAS的发布引发了关于替代模型架构的讨论,提供了探索模块化或专业化多语言设计的量化基础。

➡️