💡

原文英文,约2100词,阅读约需8分钟。

📝

内容提要

到2026年,AI模型的瓶颈将是上下文而非模型本身。AI代理需从多种数据源提取信息,缺乏关键上下文会导致响应失效。上下文引擎将通过存储和索引结构化与非结构化数据,实现更快的响应和更低的成本。现代大型语言模型(LLM)如GPT和Claude利用变换器架构和注意力机制生成连贯文本。

🎯

关键要点

- 到2026年,AI模型的瓶颈将是上下文而非模型本身。

- AI代理需从多种数据源提取信息,缺乏关键上下文会导致响应失效。

- 上下文引擎将通过存储和索引结构化与非结构化数据,实现更快的响应和更低的成本。

- 现代大型语言模型(LLM)如GPT和Claude利用变换器架构和注意力机制生成连贯文本。

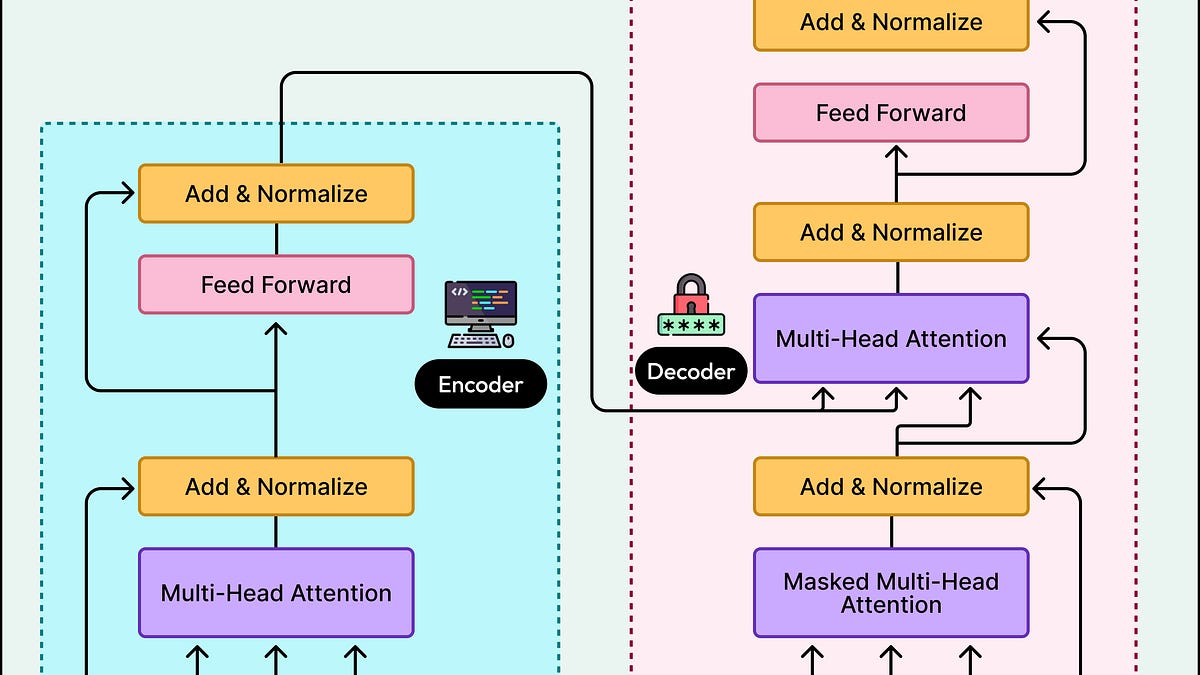

- 变换器架构由嵌入层、多层变换器和输出层组成。

- 模型通过标记化将文本转换为基本单位,称为标记。

- 标记被映射到向量,形成语义空间,相关概念聚集在一起。

- 位置嵌入用于提供单词顺序信息,结合词义和上下文。

- 注意力机制使模型能够根据上下文加权组合信息,提取重要的单词关系。

- 每层变换器学习不同的语言模式,从基本语法到抽象意义。

- 生成过程是自回归的,每个输出依赖于之前的输出。

- 训练和推理是变换器的两种不同模式,训练过程中模型学习语言模式,推理时使用已学习的权重进行预测。

- 变换器架构通过将文本转换为数值表示,使用注意力机制捕捉单词之间的关系,堆叠多层以学习抽象模式,从而生成连贯的文本。

➡️