💡

原文英文,约1800词,阅读约需7分钟。

📝

内容提要

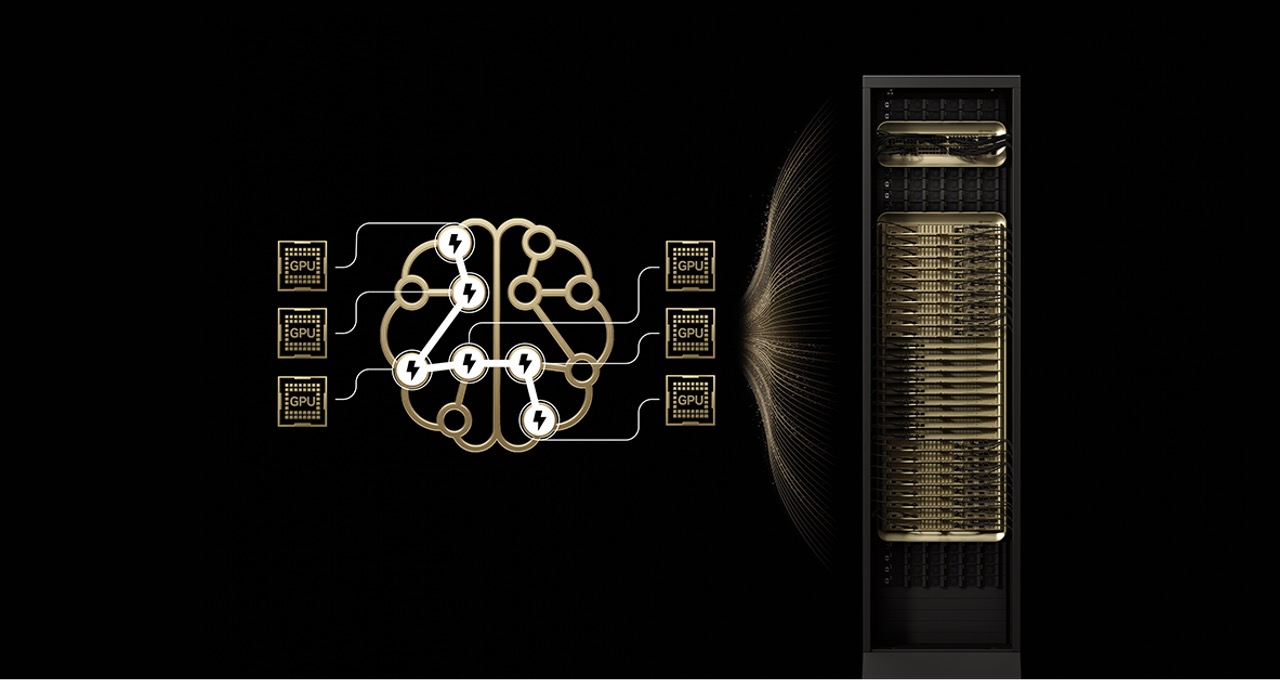

当前最先进的开源模型如Kimi K2 Thinking和Mistral Large 3采用专家混合架构(MoE),在NVIDIA GB200 NVL72上运行速度提升10倍。MoE模型通过激活特定“专家”提高效率,降低计算成本,已成为前沿模型的标准。NVIDIA的协同设计解决了MoE模型的扩展瓶颈,显著提升了性能和能效。

🎯

关键要点

- 当前最先进的开源模型如Kimi K2 Thinking和Mistral Large 3采用专家混合架构(MoE),在NVIDIA GB200 NVL72上运行速度提升10倍。

- MoE模型通过激活特定“专家”提高效率,降低计算成本,已成为前沿模型的标准。

- NVIDIA的协同设计解决了MoE模型的扩展瓶颈,显著提升了性能和能效。

- MoE模型通过选择性激活相关专家,实现更高的智能和适应性,而不增加计算成本。

- MoE架构已被超过60%的开源AI模型采用,推动了模型智能的近70倍增长。

- NVIDIA GB200 NVL72系统通过极端协同设计,解决了MoE模型的扩展瓶颈,支持多达72个GPU的专家并行。

- NVIDIA的全栈优化和Dynamo框架提升了MoE模型的推理性能,支持大规模部署。

- GB200 NVL72在每瓦特性能上实现了10倍的提升,改变了AI在数据中心的经济学。

- Kimi K2 Thinking和Mistral Large 3在GB200 NVL72上实现了10倍的性能提升,改善了用户体验和能效。

- NVIDIA GB200 NVL72系统不仅支持MoE模型,还为多模态AI模型提供强大性能,推动行业向高效、规模化的未来发展。

➡️