💡

原文英文,约900词,阅读约需4分钟。

📝

内容提要

NVIDIA推出Nemotron 3 Nano,采用混合Mamba-Transformer MoE架构,支持1M上下文长度,适合高效AI应用。该模型开源,具备出色的编码和推理能力,适用于多行业AI代理开发。

🎯

关键要点

- NVIDIA推出Nemotron 3 Nano,采用混合Mamba-Transformer MoE架构。

- Nemotron 3 Nano支持1M上下文长度,适合高效AI应用。

- 该模型开源,具备出色的编码和推理能力。

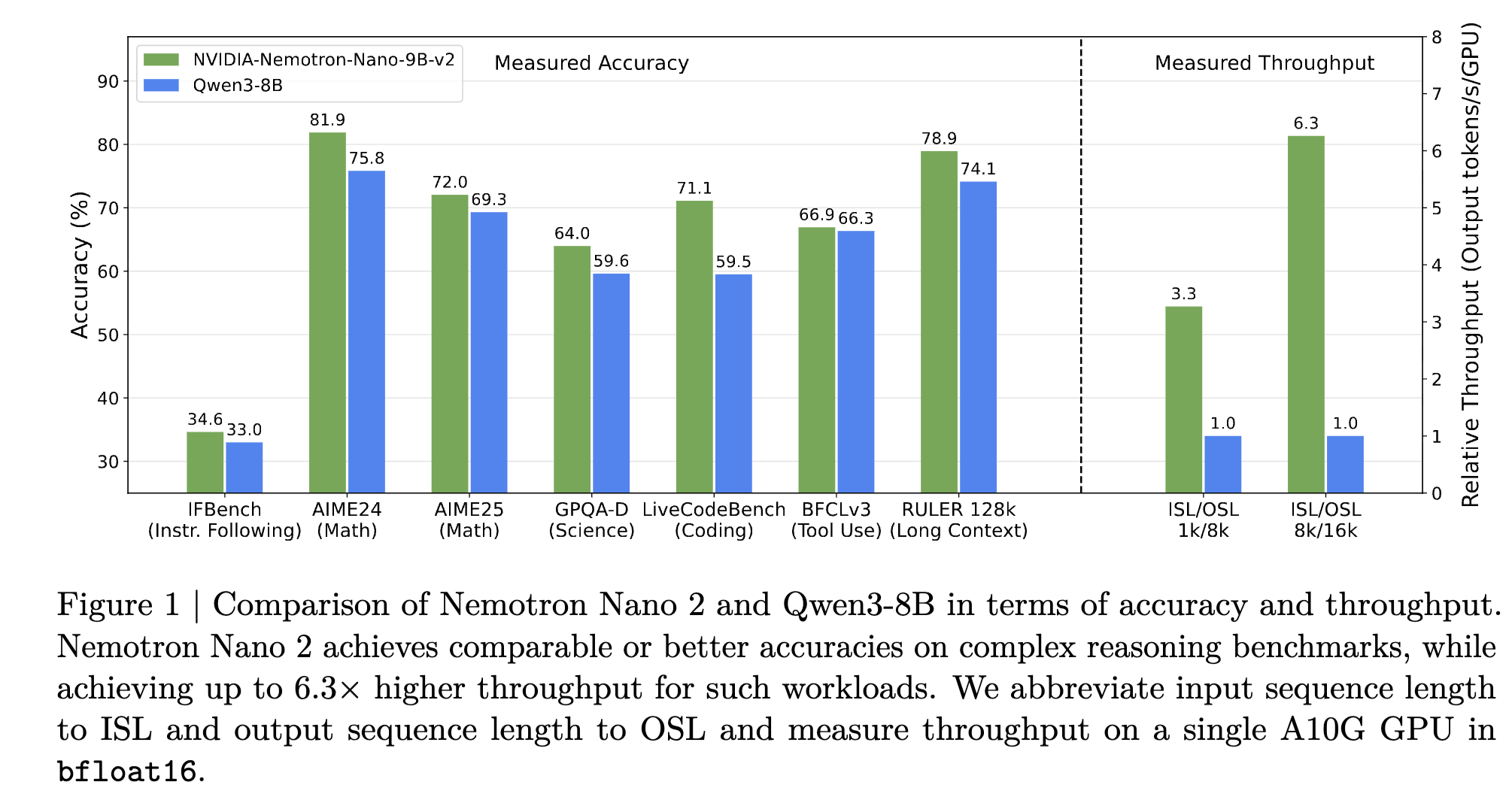

- Nemotron 3 Nano在多个基准测试中表现优异,如SWE Bench Verified和GPQA Diamond。

- 模型架构为混合专家(MoE),支持最优准确性与最小推理令牌生成。

- 模型大小为30B,具有3B活跃参数。

- 支持NVIDIA RTX Pro 6000、DGX Spark、H100和B200等GPU。

- 通过vLLM实现加速推理,支持BF16和FP8精度。

- Nemotron 3 Nano在多个行业的AI代理开发中具有广泛应用潜力。

- 开发者可以从Hugging Face下载模型权重,进行定制和优化。

➡️