💡

原文英文,约1800词,阅读约需7分钟。

📝

内容提要

视觉语言模型(VLMs)结合视觉与文本理解,适用于无障碍助手和机器人等应用。Apple的FastVLM通过高分辨率图像的混合架构显著提升了准确性和效率,解决了二者之间的权衡,适合实时应用。

🎯

关键要点

- 视觉语言模型(VLMs)结合视觉与文本理解,适用于无障碍助手、UI导航、机器人和游戏等应用。

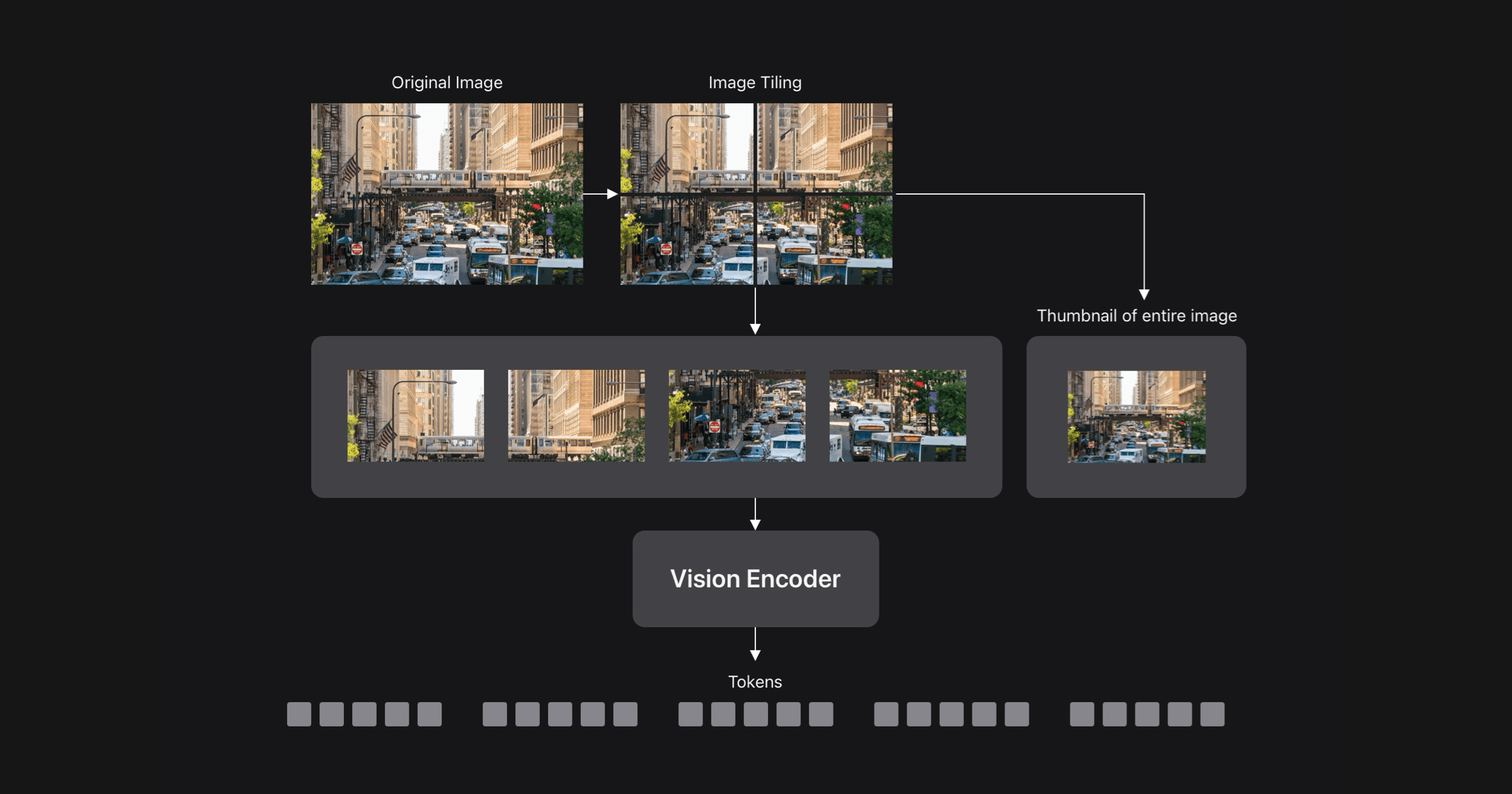

- VLM的准确性通常随着输入图像分辨率的提高而提高,但这会导致准确性与效率之间的权衡。

- Apple的FastVLM通过混合架构显著改善了准确性与延迟的权衡,适合实时应用。

- 高分辨率图像提高了VLM的准确性,但也增加了处理时间,导致时间到第一个令牌(TTFT)增加。

- FastVLM采用了新的视觉编码器FastViTHD,专为高分辨率图像设计,提供更好的准确性与延迟平衡。

- FastViTHD在高分辨率图像下的延迟表现优于FastViT,适合与不同大小的LLM结合使用。

- FastVLM的架构简单,使用多层感知器(MLP)将视觉令牌投影到LLM的嵌入空间。

- FastVLM在不同视觉令牌数量下的整体准确性高于复杂的合并或修剪方法,易于部署。

- 动态切片(如AnyRes)在处理高分辨率图像时可以提高准确性,但FastVLM在没有切片的情况下表现更佳。

- FastVLM在与同类VLM的比较中显示出更快的速度和更高的准确性,适合在设备上运行。

- FastVLM的iOS/macOS演示应用展示了其近实时性能,能够支持新的设备功能和体验。

- FastVLM通过混合架构视觉编码器解决了准确性与效率之间的权衡,适合实时设备上的视觉查询处理。

➡️