💡

原文中文,约1500字,阅读约需4分钟。

📝

内容提要

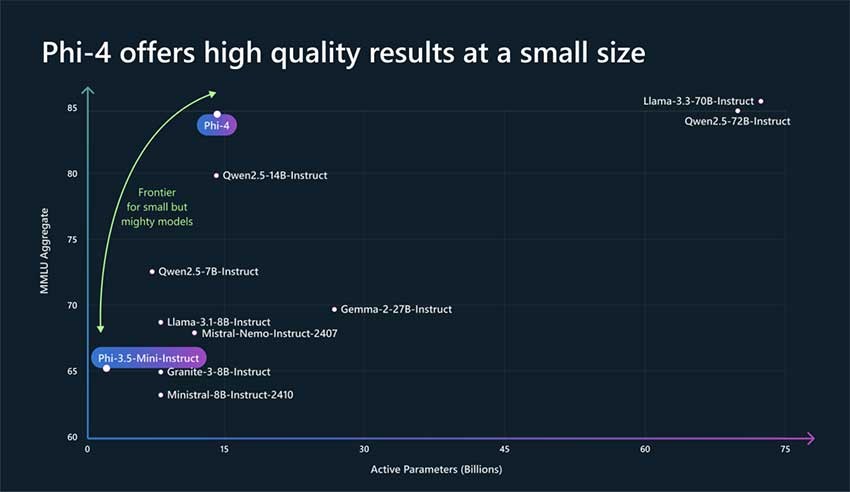

微软研究院开发的Phi-4模型拥有140亿参数,通过合成数据和训练后优化技术,在推理任务中表现优于GPT-4和Llama-3,展示了小型模型的潜力。该模型强调高质量数据和有效训练,解决了大型语言模型面临的高计算成本和数据集多样性不足的问题。

🎯

关键要点

- 大型语言模型在自然语言理解和推理任务中取得了显著进展,但面临高计算成本和数据集多样性不足的问题。

- 微软研究院开发的Phi-4模型拥有140亿参数,旨在提供更小、更高效的解决方案。

- Phi-4采用合成数据生成、课程设计和训练后优化的新方法,能够与GPT-4和Llama-3等大型模型竞争。

- 模型训练依赖高质量的合成数据,确保其在推理任务中遇到多样化和结构化的场景。

- 训练后技术如拒绝采样和直接偏好优化(DPO)提高了模型的准确性和可用性。

- Phi-4的上下文长度从4K增加到16K个token,增强了其处理长链推理任务的能力。

- 在多个基准测试中,Phi-4的表现优于GPT-4o和Llama-3,显示出其在推理密集型任务中的优势。

- Phi-4在编码基准测试HumanEval中得分82.6,并在现实世界数学竞赛中表现优异,证明其实用性。

- Phi-4的设计强调效率和推理能力,展示了较小模型也能实现与大型模型相当的结果。

- 随着人工智能的发展,Phi-4等模型展示了针对性创新在克服技术挑战中的重要性。

➡️