💡

原文中文,约1800字,阅读约需5分钟。

📝

内容提要

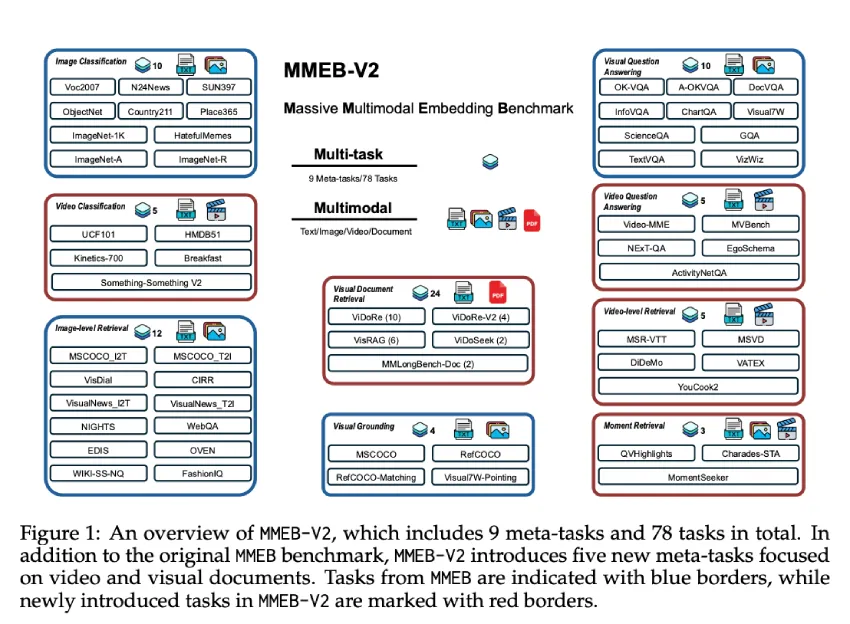

VLM2Vec-V2是一种新型多模态嵌入模型,旨在统一图像、视频和视觉文档检索。基于MMEB-V2基准,支持多种输入模态,采用Qwen2-VL作为骨干,具备动态分辨率和多模态嵌入特性,提升了对比学习的稳定性。实验结果表明,该模型在多模态任务中表现优异。

🎯

关键要点

- VLM2Vec-V2是一种新型多模态嵌入模型,旨在统一图像、视频和视觉文档检索。

- 现有多模态嵌入模型主要基于MMEB和M-BEIR等数据集,关注静态图像,无法涵盖更广泛的视觉信息。

- VLM2Vec-V2通过MMEB-V2基准扩展了五种新任务类型,包括视觉文档检索和视频分类。

- 该模型采用Qwen2-VL作为骨干架构,具备动态分辨率和多模态嵌入特性。

- VLM2Vec-V2引入灵活的数据采样流程,提高对比学习的稳定性。

- 在78个数据集中,VLM2Vec-V2获得了58.0的最高总平均分,超越了多个基线模型。

- 尽管参数规模仅为2B,VLM2Vec-V2在图像任务中的表现与VLM2Vec-7B相当。

- 在视觉文档检索方面,VLM2Vec-V2的表现优于所有变体,但仍落后于ColPali。

- VLM2Vec-V2建立在MMEB-V2之上,证明了其在跨多种模态实现均衡性能的有效性。

➡️