💡

原文英文,约800词,阅读约需3分钟。

📝

内容提要

本文介绍了一个基于TorchTitan和vLLM的开源强化学习框架,强调训练和推理过程中的位一致性。研究表明,确保数值一致性可以提高模型的训练效率和奖励。未来将致力于统一模型定义、编译支持,并扩展到其他模型,以实现更广泛的位一致性。

🎯

关键要点

- 介绍了一个基于TorchTitan和vLLM的开源强化学习框架,强调位一致性的重要性。

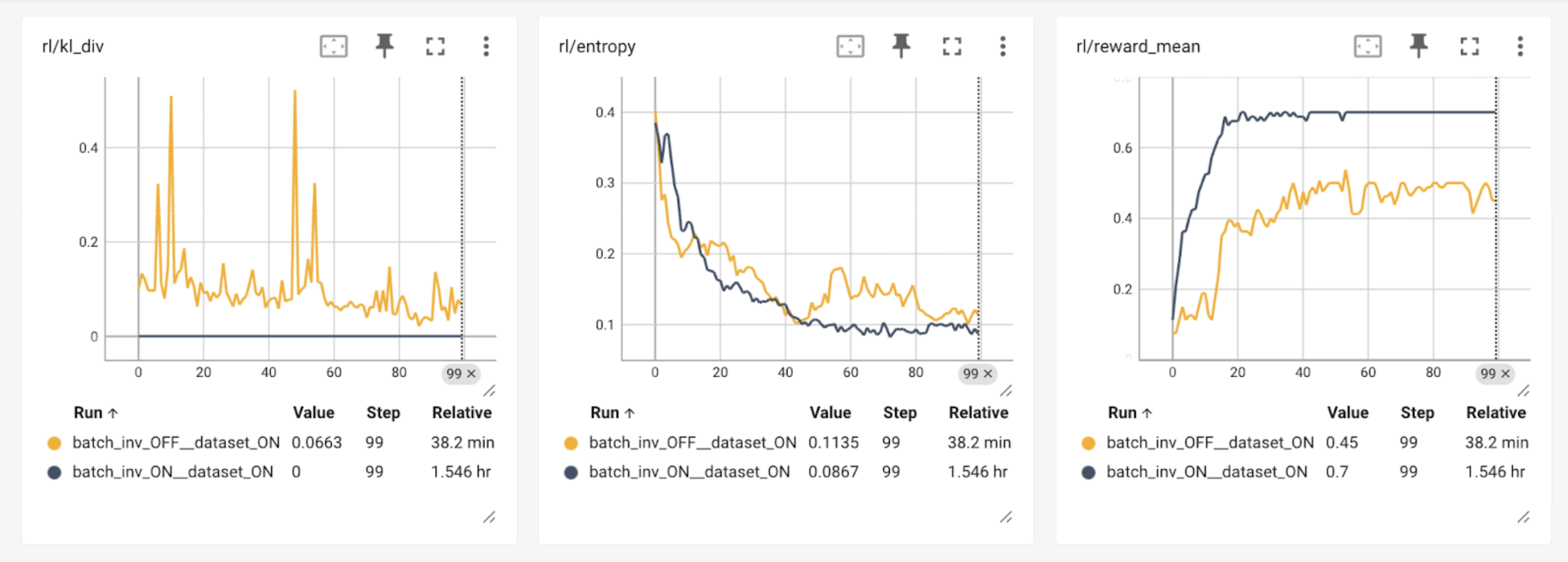

- 研究表明,数值一致性可以提高模型的训练效率和奖励。

- 训练和推理框架通常使用不同的内核,导致数值差异和不稳定的训练行为。

- 通过审计每个内核的调用,确保训练和推理框架之间的位一致性。

- 为保持位一致性,导入了vLLM的优化操作,并编写了相应的反向传播。

- 当前的强化学习结果显示,位一致性运行比非位一致性运行慢2.4倍。

- 未来将专注于统一模型定义、编译支持和扩展到其他模型,以实现更广泛的位一致性。

- 计划将位一致性强化学习框架扩展到其他开放模型,并推广审计工具和反向实现。

➡️