💡

原文英文,约2100词,阅读约需8分钟。

📝

内容提要

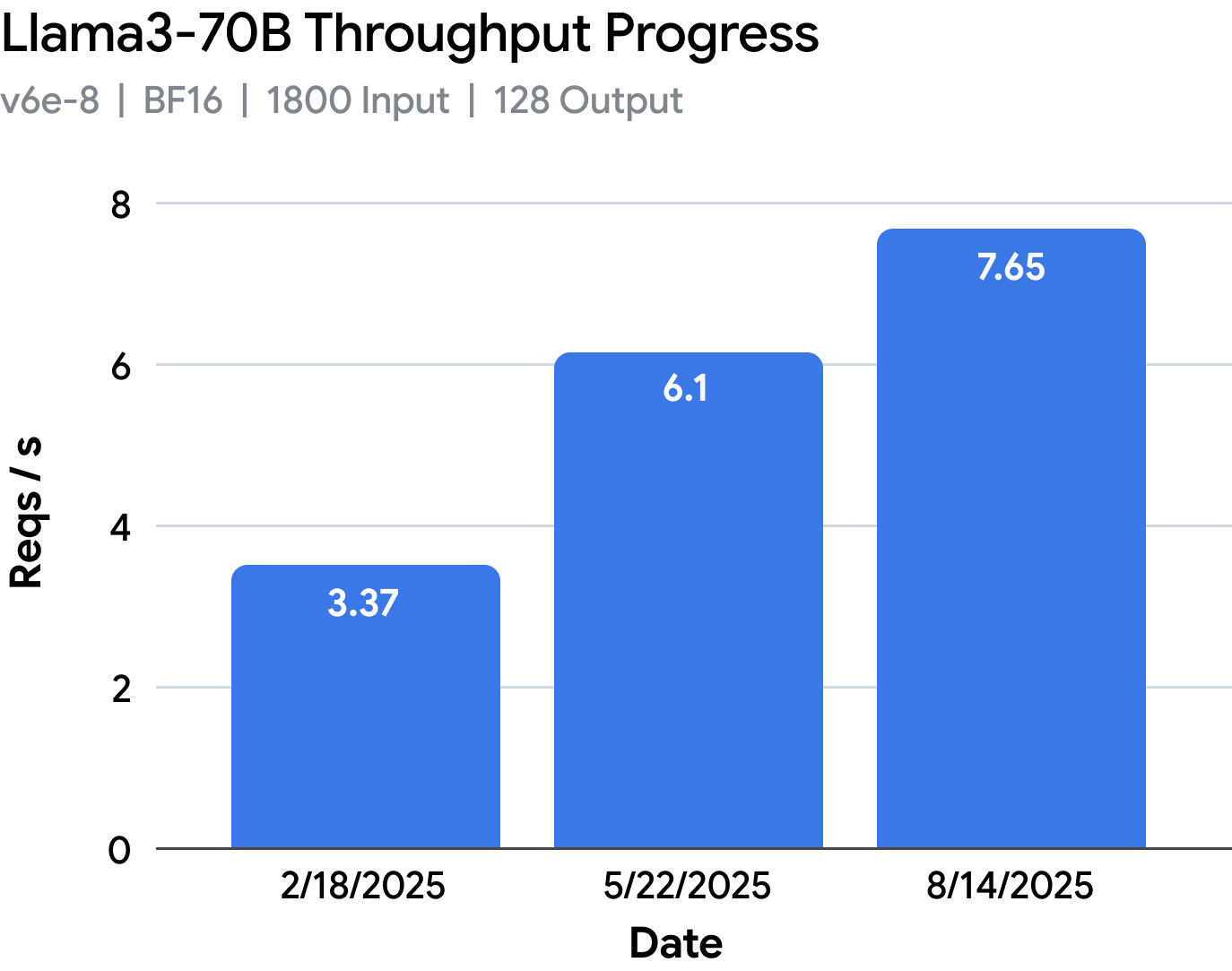

vLLM TPU通过tpu-inference插件整合JAX和PyTorch,显著提升性能和模型支持。新设计优化了TPU性能,支持多种模型,简化开发流程。RPA v3内核增强灵活性和效率,SPMD模型提升性能,整体性能较2025年原型提升近5倍,推动开源TPU推理的发展。

🎯

关键要点

- vLLM TPU通过tpu-inference插件整合JAX和PyTorch,提升性能和模型支持。

- 新设计优化TPU性能,支持多种模型,简化开发流程。

- RPA v3内核增强灵活性和效率,支持更多模型规格和量化类型。

- 整体性能较2025年原型提升近5倍,推动开源TPU推理的发展。

- SPMD成为vLLM TPU的默认编程模型,支持更高级的优化。

- vLLM TPU将定期发布新版本,持续改进模型覆盖和可用性。

- 支持的模型包括密集模型和多模态模型,未来将增加更多功能。

- 感谢vLLM社区的支持,特别是对TPU V0实现的贡献。

➡️