💡

原文中文,约2400字,阅读约需6分钟。

📝

内容提要

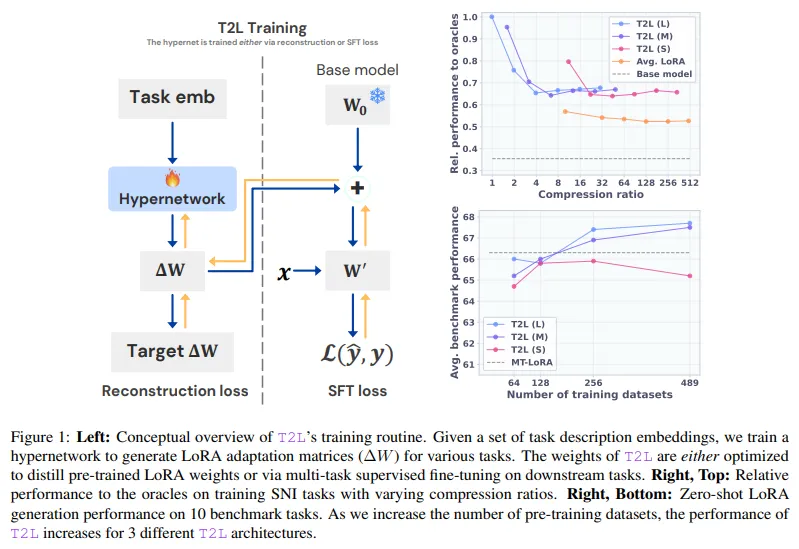

Transformer模型在自然语言处理领域取得了显著进展,但在新任务上仍需复杂的微调。研究者提出了Text-to-LoRA (T2L)技术,能够根据任务描述即时生成LoRA适配器,从而减少训练时间和成本。T2L在多个基准测试中表现优异,展现了其在模型适配方面的灵活性和高效性。

🎯

关键要点

- Transformer模型在自然语言处理领域取得显著进展,但在新任务上仍需复杂的微调。

- 研究者提出Text-to-LoRA (T2L)技术,能够根据任务描述即时生成LoRA适配器,减少训练时间和成本。

- T2L通过超网络在单次前向传递中输出适配器权重,消除了手动生成适配器的需要。

- T2L架构结合特定于模块和特定于层的嵌入来指导生成过程,支持零样本泛化。

- 测试了三种参数不同的T2L架构变体,分别为5500万、3400万和500万参数。

- T2L在多个基准测试中表现优异,如Arc-easy和BoolQ,准确率与手动训练的LoRA相当甚至超越。

- 使用超自然指令数据集的479个任务进行训练,显示出对压缩的弹性。

- T2L显著减少了将LLM适配到新领域所需的时间和成本,提升了模型在生产环境中的实用性。

🏷️

标签

➡️