💡

原文英文,约1600词,阅读约需6分钟。

📝

内容提要

语义路由系统面临扩展挑战,多个模型独立运行导致计算成本线性增长。通过重构vLLM语义路由器的分类层,采用模块化架构、低秩适应(LoRA)和并发优化,解决了这一问题。新架构支持多模型,提升了多语言处理能力和长文档支持,显著提高了分类效率和并发性能。

🎯

关键要点

- 语义路由系统面临扩展挑战,多个模型独立运行导致计算成本线性增长。

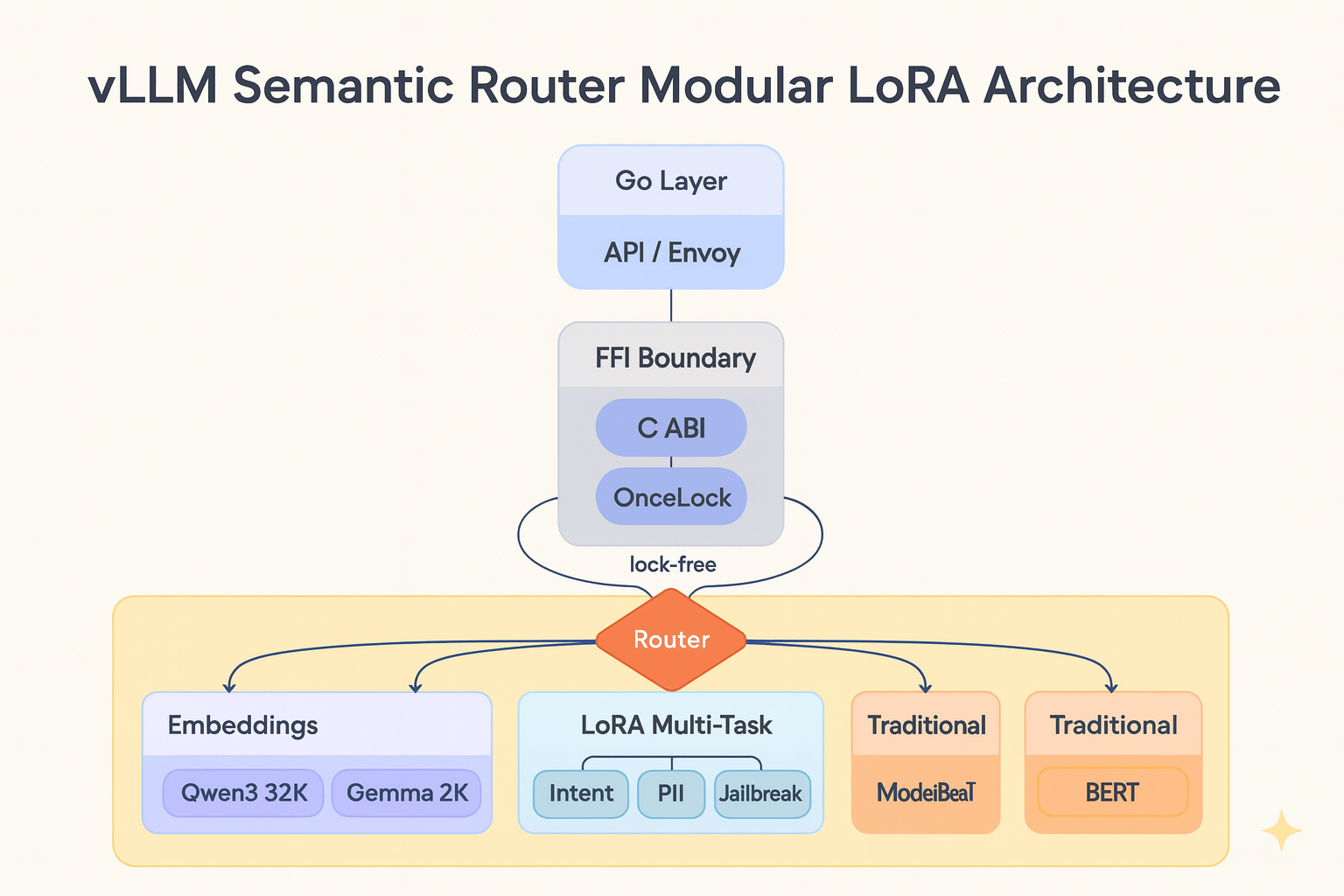

- 通过重构vLLM语义路由器的分类层,采用模块化架构、低秩适应(LoRA)和并发优化,解决了这一问题。

- 新架构支持多模型,提升了多语言处理能力和长文档支持,显著提高了分类效率和并发性能。

- 之前的实现主要依赖BERT和ModernBERT,存在语言覆盖、上下文长度和模型耦合等限制。

- 重构引入了分层架构,核心功能独立于特定模型,新模型架构可无缝集成。

- Qwen3-Embedding支持长达32,768个token的上下文,适合多语言路由场景。

- EmbeddingGemma-300M专注于小模型尺寸,同时保持质量,支持2,048个token的上下文。

- LoRA通过共享基础模型计算,显著提高了多任务分类的效率。

- OnceLock替代lazy_static,消除了锁争用,提高了并发性能。

- Flash Attention 2支持GPU加速,显著提高了注意力计算的速度和效率。

- Rust作为核心分类引擎提供高性能和内存安全,Go FFI绑定解决云原生环境中的部署挑战。

- 双语言架构提供灵活的部署选项,支持嵌入模式和进程隔离。

- 模块化架构为未来扩展提供基础,支持添加新嵌入模型和自定义LoRA适配器。

➡️