💡

原文中文,约800字,阅读约需2分钟。

📝

内容提要

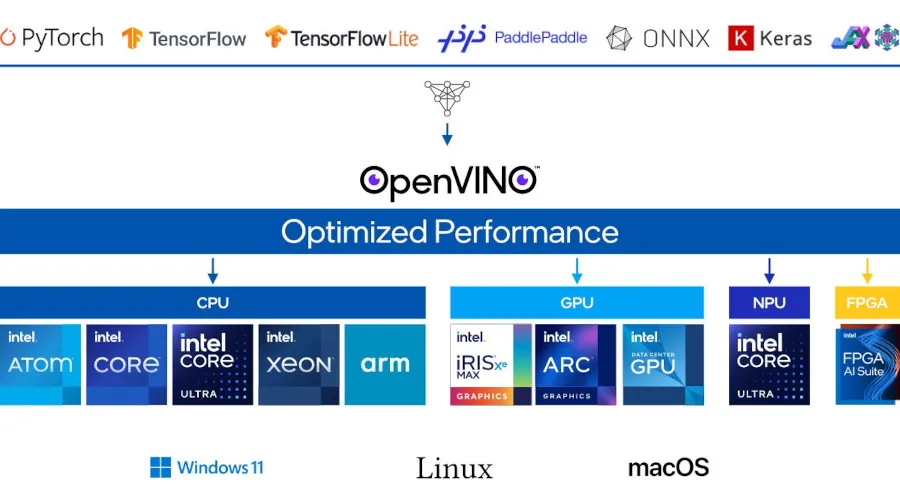

英特尔发布了 OpenVINO 2025.0,支持 Deepseek 和其他大型语言模型,提升了性能,新增 Qwen 2.5 模型。该工具包在 CPU 和 GPU 上优化了 whisper 模型,并支持 PyTorch API,改进了 LLM 的延迟,兼容新处理器和 Triton 推理服务器。

🎯

关键要点

- 英特尔发布了 OpenVINO 2025.0,支持 Deepseek 和其他大型语言模型。

- 新增支持的模型包括 Qwen 2.5、Deepseek-R1-Distill-Llama-8B 等。

- OpenVINO 2025.0 在 CPU 和 GPU 上优化了 whisper 模型性能。

- 支持 PyTorch API,英特尔 NPU 初步支持 torch.compile。

- 改进了 LLM 的第二个令牌延迟,启用了 KV 缓存压缩。

- 支持 Core Ultra 200H 处理器和 Triton 推理服务器。

- OpenVINO 模型服务器可以在 Windows Server 部署上本地运行。

➡️