💡

原文英文,约2000词,阅读约需8分钟。

📝

内容提要

CLIP是OpenAI开发的神经网络,通过学习4亿对图像和文本,实现无标注数据的图像分类。它通过匹配图像与文本描述,克服了传统计算机视觉的局限性,具有灵活性和高效性,广泛应用于AI领域。

🎯

关键要点

- CLIP是OpenAI开发的神经网络,通过学习4亿对图像和文本,实现无标注数据的图像分类。

- CLIP通过匹配图像与文本描述,克服了传统计算机视觉的局限性,具有灵活性和高效性。

- 传统计算机视觉需要大量标注数据,构建数据集既昂贵又耗时。

- CLIP通过学习来自互联网的图像-文本对,避免了对特定类别标签的预测。

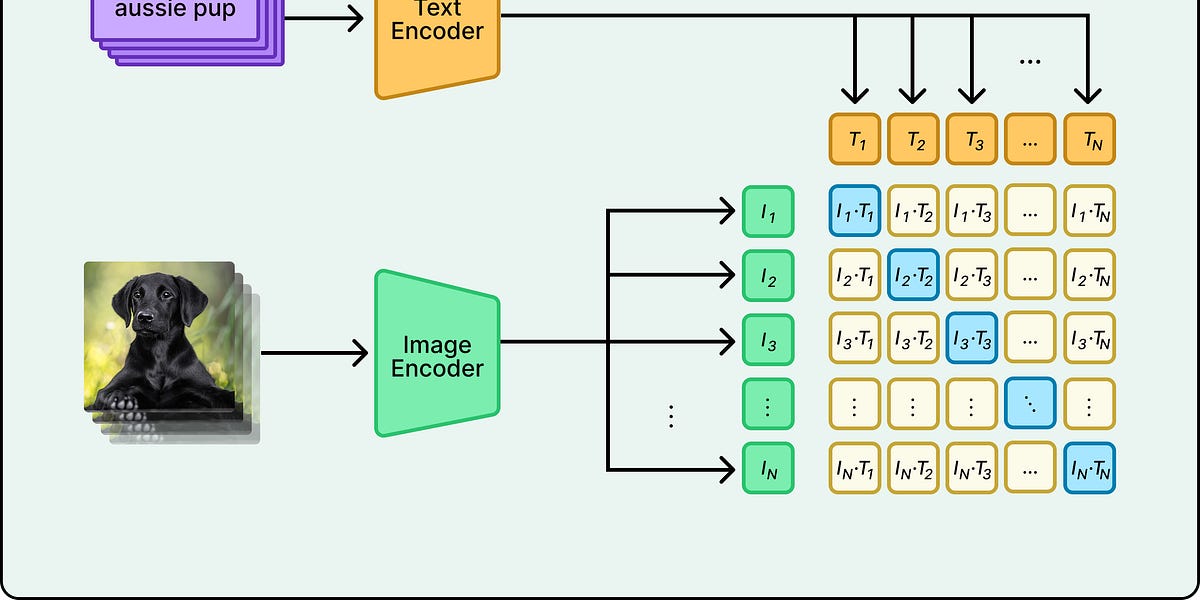

- CLIP使用对比学习和视觉变换器架构,提高了训练效率。

- CLIP的零-shot分类能力使其能够处理多种分类任务,无需重新训练。

- CLIP在多种数据集上表现出色,超越了传统模型的性能。

- 尽管CLIP有一些局限性,如对空间推理和细微区分的困难,但它展示了从互联网数据学习的潜力。

- CLIP已成为AI行业的基础设施,被广泛应用于图像搜索、内容审核和推荐系统。

➡️