💡

原文英文,约1700词,阅读约需6分钟。

📝

内容提要

英特尔Arc Pro B系列GPU具备强大的AI能力,支持本地运行大规模语言模型(LLM),优化多GPU性能和数据传输。vLLM软件栈提升推理效率,适合专业人士使用。

🎯

关键要点

- 英特尔Arc Pro B系列GPU具备强大的AI能力,支持本地运行大规模语言模型(LLM)。

- GPU具有大内存容量和多GPU扩展性,适合专业人士使用,降低AI硬件成本。

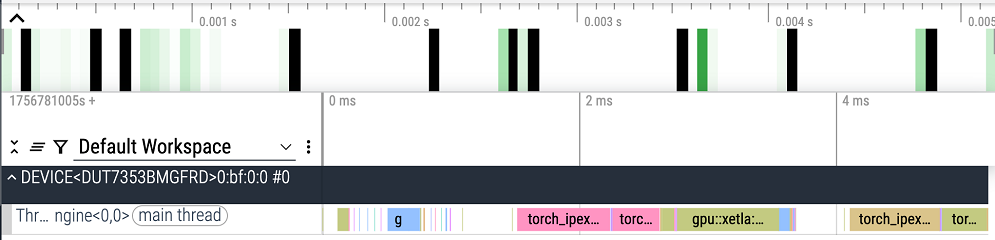

- vLLM软件栈提升推理效率,优化多GPU性能和数据传输。

- 支持多种模型特性,包括长上下文长度、嵌入、重排序和多模态模型。

- 优化Mixture of Experts (MoE)模型,提高计算效率和并行性。

- 设计持久零间隙内核,提升Intel Arc Pro B60 GPU的硬件利用率。

- 动态平衡计算组,消除小间隙,提高MoE GEMM操作的效率。

- 快速MXFP4到BFLOAT16算法,提升内存加载效率。

- Intel Arc Pro B系列GPU在高带宽VRAM和内存带宽方面表现出色,适合高触摸模型优化。

- 在MLPerf Inference v5.1中,Intel Arc Pro B60 GPU展示了性价比优势。

- 提供vllm docker镜像,支持MoE模型的运行和测试。

- 承诺深化与vLLM项目的集成,提供全面的支持和优化。

➡️